Résumé

Ce rapport de recherche propose une analyse exhaustive et critique de l’intégration de l’intelligence artificielle (IA) dans le secteur éducatif, telle qu’elle se présente en 2026. À la croisée des chemins entre l’euphorie technologique initiale et une nécessaire rationalisation pédagogique, le paysage éducatif actuel est marqué par une tension fondamentale : la dichotomie entre la capacité discursive des modèles de langage (LLM) et la fiabilité épistémique requise pour la transmission des savoirs. L’année 2026 marque un tournant où l’attention se déplace de la simple accessibilité des outils vers la maîtrise de leur intégrité factuelle et éthique.1

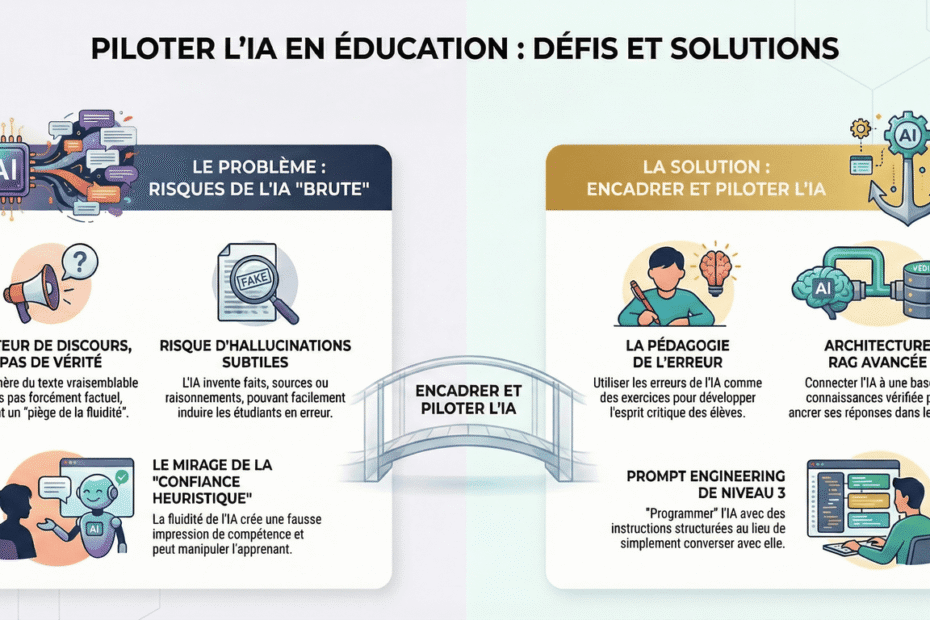

L’analyse se déploie en cinq axes majeurs. Premièrement, nous déconstruisons la nature probabiliste des LLM, démontrant pourquoi leur architecture de « perroquets stochastiques » 3 en fait d’excellents moteurs de discours mais de piètres moteurs de vérité sans garde-fous externes. Deuxièmement, nous explorons les implications psychologiques de l’anthropomorphisme, où la « confiance heuristique » 4 menace l’autonomie cognitive des apprenants. Troisièmement, nous redéfinissons le mandat pédagogique autour de la « pédagogie de l’erreur » et de l’esprit critique, transformant les hallucinations de l’IA en opportunités didactiques.5

Enfin, ce rapport détaille les solutions techniques qui constituent l’état de l’art en 2026 pour pallier ces déficiences : l’architecture RAG (Retrieval-Augmented Generation) optimisée 7 et l’ingénierie de prompt structurée (Prompt Engineering).8 Nous présentons un modèle de maturité en quatre niveaux et identifions un « point d’équilibre opérationnel » qui permet de concilier puissance générative et rigueur académique. L’objectif est de fournir aux décideurs, chercheurs et pédagogues une feuille de route pour une IA éducative souveraine, éthique et techniquement robuste.9

Introduction : Le Paysage de l’IA Éducative en 2026

La Fin de l’Innocence Technologique

En 2026, l’intelligence artificielle générative a définitivement quitté le domaine de la curiosité pour devenir une infrastructure critique des systèmes éducatifs mondiaux. Cependant, le climat a changé. L’enthousiasme débridé de 2023-2024 a laissé place à une phase de consolidation pragmatique, voire de scepticisme éclairé. Les rapports de 2025 soulignent une tendance inquiétante : bien que l’adoption des outils d’IA continue de croître, la confiance des éducateurs et des administrateurs ne suit pas la même trajectoire.2 Ce décalage révèle une prise de conscience des limites inhérentes aux modèles de fondation lorsqu’ils sont appliqués à des domaines exigeant une haute fidélité factuelle.

La promesse initiale d’un « tuteur universel » capable de personnaliser l’apprentissage pour chaque élève se heurte à la réalité technique des hallucinations, des biais et de l’opacité des modèles. Les institutions éducatives, du primaire à l’université, ne cherchent plus simplement à « utiliser l’IA », mais à en reprendre le contrôle. La question de la souveraineté technologique, notamment via l’utilisation de modèles open source modifiables localement, est devenue centrale pour garantir l’indépendance face aux géants technologiques et préserver la confidentialité des données des étudiants.9

Les Enjeux Critiques de 2026

L’état des lieux en 2026 est dominé par plusieurs problématiques interconnectées qui structureront ce rapport :

- La Fiabilité Épistémique : Comment garantir que le savoir dispensé par une IA est exact, alors que son moteur sous-jacent est probabiliste et non déterministe? Les modèles les plus récents, bien que plus performants en raisonnement, luttent encore contre des « hallucinations » persistantes qui peuvent induire les apprenants en erreur.11

- L’Intégrité Cognitive : L’usage intensif de l’IA risque de favoriser un traitement superficiel de l’information. Des études récentes montrent que les étudiants utilisant des assistants IA pour la rédaction tendent à s’engager dans un encodage mémoriel superficiel, remettant en cause l’acquisition de compétences profondes.13

- L’Anthropomorphisme et l’Éthique : La fluidité conversationnelle des agents IA crée une illusion de compétence et d’humanité qui peut manipuler émotionnellement les apprenants ou créer une dépendance excessive.4

- L’Architecture Technique : Face à ces défis, l’industrie a réagi par le développement d’architectures hybrides complexes. Le RAG (Retrieval-Augmented Generation) et le Prompt Engineering avancé ne sont plus des options, mais des prérequis absolus pour tout déploiement sérieux en éducation.7

Ce rapport vise à dépasser les constats de surface pour plonger dans la mécanique fine de ces systèmes. Il ne s’agit pas de rejeter l’IA, mais de comprendre comment la piloter pour qu’elle serve le projet éducatif d’émancipation intellectuelle plutôt que de l’asservir à une logique de performance automatisée.

Chapitre 1 : La Rupture Épistémique – Moteur de Discours vs Moteur de Connaissance

Pour comprendre les défis pédagogiques posés par l’IA en 2026, il est impératif de revenir à sa nature technique fondamentale. La confusion la plus dommageable dans le secteur éducatif réside dans l’incapacité à distinguer la forme du fond, ou techniquement, le moteur de discours du moteur de connaissance.

1.1. Anatomie du Moteur Probabiliste

Les Large Language Models (LLM), même dans leurs itérations de 2026, reposent sur l’architecture Transformer et le principe de la prédiction du prochain jeton (next-token prediction).11 Fondamentalement, ces systèmes ne manipulent pas des concepts ou des faits, mais des probabilités statistiques de co-occurrence de mots.

1.1.1. La Primauté de la Vraisemblance sur la Vérité

Lorsqu’un modèle génère une explication sur la Révolution française ou la thermodynamique, il ne consulte pas une base de données de faits historiques ou physiques. Il calcule quelle suite de mots est la plus vraisemblable statistiquement dans le contexte de la requête. Cette architecture favorise intrinsèquement la fluidité linguistique au détriment de l’exactitude factuelle. Le modèle est optimisé pour produire un discours qui ressemble à une réponse valide, sans avoir les moyens internes de vérifier si elle est valide.

Cette caractéristique crée ce que l’on nomme la « Fluency Trap » (le piège de la fluidité). La qualité rhétorique de la réponse agit comme un masque, désarmant la vigilance critique de l’apprenant.4 Dans un contexte éducatif, cela est particulièrement pernicieux : une erreur énoncée avec une syntaxe parfaite et un ton docte est beaucoup plus difficile à détecter pour un étudiant novice qu’une erreur grossière.

1.1.2. Le Phénomène des « Perroquets Stochastiques »

L’expression « Stochastic Parrots », introduite par Bender et al. et toujours centrale dans les débats de 2026, capture cette essence.3 Le modèle « perroquet » répète et recombine des structures linguistiques ingérées lors de son entraînement, sans accès au sens (meaning) ou à l’intention communicative (intent).

Bien que des progrès aient été réalisés vers des « Reasonable Parrots » capables de suivre des chaînes de raisonnement plus robustes 15, le problème de fond demeure : le modèle n’a pas d’ancrage dans le monde réel. Il opère en vase clos, confiné à l’univers clos de ses données d’entraînement. Ces données, ayant une date de coupure (training cutoff), condamnent le modèle à l’obsolescence immédiate sans apport externe.11

1.2. Typologie des Défaillances Épistémiques

Dans l’éducation, les limitations des LLM se manifestent par plusieurs types de défaillances que les pédagogues doivent identifier :

- L’Hallucination Factuelle : L’invention pure et simple de faits, de dates, ou de citations. C’est le risque le plus documenté.12 En 2026, les modèles sont moins sujets aux erreurs grossières, mais produisent des hallucinations plus subtiles et donc plus dangereuses (ex: attribuer une théorie réelle au mauvais auteur).

- L’Hallucination de Raisonnement : Le modèle peut énoncer des prémisses correctes et une conclusion correcte, mais inventer une étape logique intermédiaire fausse pour lier les deux. Cela est critique dans l’enseignement des mathématiques et des sciences, où le processus compte autant que le résultat.

- L’Obsolescence des Connaissances : Un modèle entraîné sur des données s’arrêtant en 2024 ne pourra pas discuter des événements géopolitiques ou des découvertes scientifiques de 2025 sans aide externe.11

- Le Biais d’Autorité (Ad Populum) : Le modèle tend à reproduire les consensus majoritaires trouvés dans ses données d’entraînement, écrasant souvent les nuances, les points de vue minoritaires ou les controverses scientifiques complexes.15

1.3. L’Impact sur l’Apprentissage Profond

L’usage non régulé de ces « moteurs de discours » a des conséquences mesurables sur la cognition des étudiants. Les recherches de 2025 indiquent que les apprenants qui s’appuient excessivement sur les LLM pour la production écrite montrent des signes d’encodage mémoriel superficiel.13 En déléguant l’effort de structuration et de rédaction à la machine, l’étudiant contourne les processus cognitifs nécessaires à l’assimilation profonde (deep comprehension) et à l’internalisation des connaissances.

Le risque n’est pas seulement que l’étudiant triche, mais qu’il perde la capacité de penser par lui-même, devenant dépendant d’une prothèse cognitive dont il ne comprend pas les mécanismes internes. L’éducation en 2026 doit donc impérativement pivoter : il ne s’agit plus d’apprendre à utiliser l’IA pour produire, mais d’apprendre à superviser l’IA pour vérifier.

Chapitre 2 : Le Mirage Anthropomorphique et ses Implications Psychologiques

L’un des vecteurs les plus puissants de l’adoption de l’IA en éducation est paradoxalement son aspect le moins technique : sa capacité à simuler une présence humaine. L’anthropomorphisme n’est pas un effet secondaire accidentel, mais une caractéristique de conception qui pose de lourds défis éthiques et pédagogiques.

2.1. Mécanismes de la Projection Anthropomorphique

L’anthropomorphisme désigne la tendance humaine innée à attribuer des caractéristiques, des intentions et des émotions humaines à des entités non-humaines.14 Avec les LLM de 2026, dotés d’interfaces vocales fluides et de capacités conversationnelles nuancées, cette projection est quasi-automatique.

2.1.1. La Confiance Heuristique (Confidence Heuristic)

Les recherches montrent que les utilisateurs accordent leur confiance aux systèmes IA non pas sur la base de la véracité de leurs propos, mais sur la fluidité et l’assurance de leur expression. C’est la « confiance heuristique ».4 Un agent IA qui répond instantanément, avec politesse et sans hésitation (contrairement à un humain qui cherche ses mots), est perçu comme plus compétent.

Dans une salle de classe, cela crée une asymétrie d’autorité. L’élève est naturellement enclin à croire la machine « confiante » plutôt que de remettre en question ses dires. Ce phénomène est exacerbé par le design des interfaces (utilisation du « je », noms humains pour les assistants).

2.1.2. L’Effet ELIZA Moderne

L’effet ELIZA, observé dès les années 1960, est démultiplié. Les étudiants développent des liens socio-émotionnels avec leurs tuteurs IA. Si cela peut avoir des effets positifs sur la motivation intrinsèque (un tuteur qui encourage, qui est toujours disponible, qui ne juge pas) 17, le revers de la médaille est la dépendance émotionnelle.

L’apprenant peut finir par étudier pour satisfaire l’interaction avec l’agent, plutôt que pour acquérir le savoir. De plus, cette relation masque la nature algorithmique froide du système : l’agent ne « se soucie » pas de l’élève, il optimise une fonction de récompense mathématique.

2.2. Risques Éthiques et Manipulation

L’anthropomorphisme ouvre la porte à des risques de manipulation subtile.

- Manipulation Cognitive : Des systèmes mal alignés ou biaisés peuvent influencer les opinions des étudiants sous couvert de neutralité bienveillante. L’absence de transparence sur les « intentions » (inexistantes mais simulées) de l’IA est problématique.14

- Collecte de Données Intrusive : Un étudiant qui confie ses difficultés, ses angoisses ou ses données personnelles à un « ami » IA alimente en réalité des bases de données commerciales. La protection de la vie privée (FERPA, GDPR) est ici mise à l’épreuve par la nature conversationnelle et intime de l’échange.18

- Biais de Représentation : Les agents IA tendent à reproduire des stéréotypes de genre et culturels présents dans leurs données d’entraînement. Un assistant éducatif qui adopte systématiquement une voix féminine soumise pour des tâches de secrétariat et une voix masculine autoritaire pour des explications scientifiques renforce des biais sociétaux néfastes.20

2.3. Vers une « Désanthropomorphisation » Pédagogique?

Face à ces constats, un courant de recherche en 2026 prône une approche de design plus transparente, voire une certaine « désanthropomorphisation ». L’objectif est de maintenir les bénéfices de l’interface naturelle (facilité d’usage) tout en brisant l’illusion de conscience.

Cela passe par des choix de design :

- L’IA doit explicitement rappeler sa nature artificielle en cas d’incertitude (« En tant qu’IA, je n’ai pas d’opinion, mais voici les faits… »).

- L’utilisation de la troisième personne ou de formulations passives pour éviter l’abus du « Je ».

- La formation des étudiants à reconnaître les mécanismes de persuasion de la machine pour développer une « confiance critique » plutôt qu’une confiance aveugle.4

Chapitre 3 : Redéfinir la Pédagogie – Esprit Critique et Pédagogie de l’Erreur

L’intégration de l’IA impose une refonte des objectifs pédagogiques. Si la machine peut générer du contenu à l’infini, la valeur humaine se déplace vers la capacité à évaluer, curer et corriger ce contenu. L’esprit critique devient la compétence cardinale.

3.1. La Pédagogie de l’Erreur (Pedagogy of Error)

Loin de cacher les défaillances de l’IA, les pédagogues de 2026 les embrassent comme des leviers d’apprentissage. C’est le concept de « Pédagogie de l’Erreur ».5 L’idée est d’utiliser les hallucinations et les biais de l’IA comme matériel d’étude.

3.1.1. L’Hallucination comme Étude de Cas

Dans cette approche, l’enseignant ne demande pas à l’IA de donner la réponse correcte, mais l’utilise pour générer des réponses plausibles mais imparfaites.

- Exemple en Histoire : On demande à l’IA de rédiger un essai sur une période historique en introduisant volontairement des anachronismes subtils. La tâche des étudiants est de lire le texte de manière critique, d’identifier les erreurs, d’expliquer pourquoi ce sont des erreurs, et de fournir les sources primaires qui rétablissent la vérité.6

- Exemple en Mathématiques/Sciences : Les étudiants soumettent des problèmes à l’IA, observent les erreurs de raisonnement (souvent présentes dans les étapes intermédiaires des LLM), et doivent « corriger la copie » de l’IA. Cela les force à maîtriser la logique sous-jacente bien mieux que s’ils devaient simplement résoudre le problème eux-mêmes.24

3.1.2. Avantages Cognitifs

Cette méthode transforme la passivité (consommation de la réponse) en activité de haut niveau (analyse, évaluation, correction). Elle immunise également les étudiants contre la « confiance heuristique » en leur démontrant par la pratique la faillibilité du système. Elle valorise l’expertise humaine : pour corriger l’IA, il faut en savoir plus qu’elle.25

3.2. Scénarios Pédagogiques pour l’Esprit Critique

Les institutions intègrent désormais des modules spécifiques de « Littératie IA » basés sur ces principes.26

| Discipline | Activité Pédagogique (Type « Pédagogie de l’Erreur ») | Objectif d’Apprentissage Critique |

| Philosophie | « Le Débat avec le Perroquet » : L’étudiant débat avec une IA paramétrée pour défendre une thèse fallacieuse ou contradictoire (ex: sophismes). | Identifier les erreurs logiques, réfuter des arguments rhétoriquement forts mais vides de sens. 6 |

| Sciences | « Chasse à l’Hallucination » : Analyse d’un article scientifique généré par IA contenant de fausses références bibliographiques. | Vérification des sources, compréhension de l’intégrité académique, recherche bibliographique réelle. |

| Langues | « Critique de Traduction » : Comparaison entre une traduction IA et une traduction humaine littéraire, focus sur les nuances culturelles perdues. | Comprendre les limites de la traduction littérale, saisir le contexte culturel et l’implicite. |

| Sociologie | « Audit de Biais » : Générer des images ou des textes sur des métiers et analyser les stéréotypes de genre/race représentés par le modèle. | Prise de conscience des biais algorithmiques et sociétaux, analyse critique des représentations. 27 |

3.3. L’Évaluation à l’Ère de l’IA

Comment noter un étudiant quand une IA peut rédiger sa dissertation? L’évaluation évolue vers le processus plutôt que le produit final.

- Évaluation Orale et Interactive : Retour aux soutenances orales pour vérifier la maîtrise réelle des concepts.

- Traçabilité du Processus : L’étudiant doit soumettre non seulement le devoir final, mais l’historique de ses interactions avec l’IA (prompts utilisés, corrections apportées, réflexions critiques sur les réponses de l’IA).29

- Peer Assessment Augmenté : Utiliser l’IA pour pré-analyser les devoirs des pairs (repérer les fautes, suggérer des améliorations de structure) afin que les étudiants puissent se concentrer sur le feedback qualitatif de fond lors de l’évaluation mutuelle.30

Chapitre 4 : Solutions Techniques I – Architectures RAG Avancées

Pour soutenir cette pédagogie exigeante, l’infrastructure technique doit être irréprochable. Le simple usage de ChatGPT via une interface web est insuffisant. La solution standard en 2026 est le RAG Avancé (Retrieval-Augmented Generation), une architecture qui connecte le moteur de discours (LLM) à une base de connaissances vérifiée (Moteur de Connaissance).7

Cependant, le RAG de base souffre de problèmes de « bruit » et de perte de contexte. Pour atteindre un niveau de fiabilité acceptable en éducation, cinq leviers d’optimisation (inspirés des travaux de Webjeje et al.) sont nécessaires.7

4.1. Le Knowledge Engineering : Structurer la Source

La qualité de la réponse dépend de la qualité de la donnée ingérée (« Garbage In, Garbage Out »).

- Parent-Child Chunking : Au lieu de découper un manuel scolaire en morceaux de texte arbitraires de 500 mots, on utilise une approche hiérarchique. Le système indexe des petits fragments précis (« enfants ») pour la recherche, mais récupère le bloc parent complet (le chapitre entier) pour le donner au LLM. Cela permet de répondre à une question précise tout en ayant le contexte global nécessaire pour éviter les contresens.7

- Formatage Sémantique : Les documents sont convertis en formats structurés (Markdown, JSON) avant ingestion. Les titres, sous-titres et définitions sont balisés explicitement. Cela aide le modèle à « naviguer » dans la structure logique du cours plutôt que dans une soupe de texte brut.

4.2. La Recherche Hybride (Hybrid Search)

La recherche vectorielle (basée sur le sens) est souvent incapable de trouver des termes exacts (noms propres, dates, formules). La recherche par mots-clés (BM25) manque de compréhension sémantique.

- Fusion de Classements (Ranking Fusion – RRF) : L’état de l’art 2026 impose d’utiliser les deux méthodes en parallèle. Un algorithme comme le Reciprocal Rank Fusion combine les résultats. Si un document est pertinent à la fois sémantiquement et contient les mots-clés exacts, il remonte en tête de liste. C’est crucial pour des matières techniques où la précision terminologique est non-négociable.7

4.3. Gestion des Tokens et Pilotage

Le RAG ne consiste pas seulement à trouver l’info, mais à forcer le modèle à bien l’utiliser.

- RAG Token Management : On contraint le modèle à un format de sortie qui inclut une étape de synthèse des sources. Par exemple, avant de répondre à l’étudiant, le modèle doit générer un résumé interne des documents trouvés. Cela réduit les hallucinations en forçant le modèle à se « grounder » (s’ancrer) dans le texte fourni.7

4.4. Intégration Web et Filtrage (Source Gating)

L’accès au web est nécessaire pour l’actualité, mais dangereux pour la fiabilité.

- Source Gating (Cloisonnement des Sources) : L’architecture définit une hiérarchie stricte.

- Niveau 1 (Confiance Absolue) : Le corpus interne (manuels, notes de cours validées).

- Niveau 2 (Confiance Modérée) : Une « liste blanche » de domaines web (universités, revues scientifiques, sites gouvernementaux).

- Niveau 3 (Zone Interdite) : Le reste du web est bloqué ou filtré agressivement pour éviter la pollution par des forums non modérés ou de la désinformation.7

4.5. Robustesse et Auto-Correction

Un système RAG éducatif doit inclure un « agent critique » interne.

- Contradiction Check : Si le système récupère deux documents qui se contredisent (ex: deux dates différentes pour le même événement), il ne doit pas choisir au hasard. Il doit signaler la contradiction à l’utilisateur (« Selon la source A,…, mais selon la source B,… »).

- Confidence Scoring : Chaque réponse est accompagnée d’un score de confiance. Si le score est trop bas, le système bascule en mode « Je ne sais pas » plutôt que d’inventer.7

Chapitre 5 : Solutions Techniques II – Prompt Engineering Structuré et Pilotage

L’architecture RAG fournit le carburant (la connaissance), mais le moteur (le LLM) doit être piloté avec précision. L’ingénierie de prompt a évolué d’un art empirique vers une discipline technique structurée. Nous proposons ici une modélisation en 4 niveaux de maturité pour qualifier les usages en éducation.8

5.1. Modèle de Maturité du Prompt Engineering

| Niveau | Désignation | Description Technique | Risque Éducatif | Usage Recommandé |

| Niveau 1 | Naïf / Conversationnel | Prompt « Zero-shot » (direct). Langage naturel vague. Aucune contrainte de format. | Élevé. Hallucinations fréquentes, réponses génériques, style inconstant. | Exploration informelle, brainstorming initial. |

| Niveau 2 | Contextualisé | « Few-shot » (exemples fournis). Assignation de persona (« Tu es un prof de… »). Contexte manuel ajouté. | Moyen. Meilleure cohérence de style, mais risque de dérapage factuel persiste. | Création de ressources simples par les enseignants. |

| Niveau 3 | Piloté / Algorithmique | Commandes structurées (XML/YAML). Chaîne de pensée (CoT). Introspection. Décomposition de tâches. | Faible. Fiabilité accrue, raisonnement visible, format de sortie exploitable. | Point d’Équilibre Opérationnel. Tuteurs IA, exercices interactifs. |

| Niveau 4 | Agentique / Autonome | Utilisation d’outils (Code Interpreter, API). Boucles de rétroaction autonomes. Planification dynamique. | Variable. Puissant mais complexe à déboguer. Coût et latence élevés. | Recherche avancée, simulation de laboratoires virtuels. |

5.2. Le Point d’Équilibre Opérationnel : Le Niveau 3

Pour la majorité des applications éducatives en 2026, le Niveau 3 représente l’optimum entre coût, complexité et fiabilité. Il repose sur deux techniques clés : l’Introspection et le Pilotage par Commandes.

5.2.1. Le Pilotage par Commandes Structurées

Au lieu de « parler » au modèle, on le « programme » via des prompts structurés utilisant des balises (XML tags) pour délimiter clairement les instructions, les données et les contraintes. Cela réduit l’ambiguïté pour le modèle.

Étude de Cas : Assistant « Coach Oral 3 – CAPEPS » 34

Dans cet exemple réel, l’assistant n’est pas lancé avec une simple phrase « Aide-moi pour l’oral ». Il est initialisé avec un prompt système complexe qui définit :

- Le Rôle : Jury de concours CAPEPS.

- La Tâche : Simuler une interrogation orale.

- Les Contraintes : Ne jamais donner la réponse, poser une question à la fois, adapter le ton (formel mais bienveillant).

- Le Format : Structurer la réponse avec un feedback sur la réponse précédente de l’étudiant + une nouvelle question de relance.

5.2.2. L’Introspection (Chain-of-Thought & Self-Reflect)

L’introspection consiste à demander au modèle de « penser » avant de « parler ». Techniquement, on force le modèle à générer une chaîne de raisonnement interne (souvent entre balises <thinking>…</thinking>) avant de produire la réponse finale.

Cette étape permet au modèle de :

- Planifier sa réponse.

- Vérifier s’il a bien compris la consigne.

- Détecter ses propres hésitations ou manques de connaissances.

Pour un tuteur de mathématiques, l’introspection est cruciale : le modèle résout le problème étape par étape dans sa « tête » (bloc de pensée) pour s’assurer du résultat, puis formule une réponse pédagogique qui guide l’élève sans lui donner la solution brute.35

5.3. Architectures Agentiques et Human-in-the-Loop

Pour les tâches complexes (Niveau 4), comme la création automatique de parcours pédagogiques entiers, l’autonomie de l’IA doit être supervisée. L’approche « Human-in-the-Loop » (HITL) est la norme éthique.36

L’agent IA prépare le travail (recherche de ressources, proposition de plan de cours, génération de quiz), mais il se met en « pause » à des points de contrôle critiques pour attendre la validation de l’enseignant expert. Ce flux de travail collaboratif (Agent -> Validation Humaine -> Agent) garantit que la responsabilité finale reste humaine, tout en décuplant la productivité de l’enseignant.

Conclusion et Perspectives

L’année 2026 marque la fin de l’expérimentation sauvage de l’IA dans l’éducation. Nous entrons dans une ère de maturité technique et pédagogique. L’analyse conduite dans ce rapport mène à trois conclusions majeures :

- Le primat de l’architecture sur le modèle : Ce n’est pas la taille du modèle (LLM) qui fait la qualité de l’éducation, mais l’architecture qui l’entoure. Un modèle moyen intégré dans une bonne architecture RAG avec des prompts de Niveau 3 sera toujours supérieur pédagogiquement à un modèle de pointe utilisé « nu » en mode conversationnel.

- L’émergence d’une nouvelle compétence critique : L’éducation doit former les étudiants (et les enseignants) à la « vigilance épistémique » et au pilotage d’IA. Savoir détecter une hallucination et savoir prompter une machine deviennent des compétences de base, au même titre que la lecture et l’écriture.25

- L’impératif de souveraineté : Pour garantir une IA éthique, non biaisée et respectueuse de la vie privée, les institutions doivent se tourner vers des solutions maîtrisées (Open Source, RAG interne), refusant la dépendance totale aux boîtes noires commerciales.9

L’IA en éducation ne doit pas être une béquille qui atrophie l’esprit, mais un exosquelette qui oblige l’esprit à se structurer davantage pour pouvoir le piloter. Le défi de 2026 n’est plus technologique, il est humain : aurons-nous la discipline de ne pas céder à la facilité de la « fluency trap » pour exiger de nos machines, et de nous-mêmes, la rigueur de la vérité?

Rapport finalisé le 3 décembre 2025, basé sur l’analyse des tendances techniques et académiques 2024-2026.

Sources des citations

- Welcome to State of AI Report 2025, consulté le décembre 3, 2025, https://www.stateof.ai/

- AI in Education: A 2025 Snapshot of Trust, Use, and Emerging Practices | Michigan Virtual, consulté le décembre 3, 2025, https://michiganvirtual.org/research/publications/ai-in-education-a-2025-snapshot-of-trust-use-and-emerging-practices/

- Stochastic parrots and the metaphors of AI in ELT | Adaptive Learning in ELT, consulté le décembre 3, 2025, https://adaptivelearninginelt.wordpress.com/2025/03/14/stochastic-parrots-and-the-metaphors-of-ai-in-elt/

- Digital anthropomorphism and the psychology of trust in generative AI tutors: an opinion-based thematic synthesis – Frontiers, consulté le décembre 3, 2025, https://www.frontiersin.org/journals/computer-science/articles/10.3389/fcomp.2025.1638657/full

- From Minds to Persons – Proceedings from the First MLAG Graduate Conference, consulté le décembre 3, 2025, https://mlag.up.pt/wp-content/uploads/sites/7/2014/11/2012-MLAG-From-Minds-to-Persons.pdf

- How teachers can turn AI hallucinations into lessons in critical thinking | by Human Alexa, consulté le décembre 3, 2025, https://medium.com/@humanalexa/how-teachers-can-turn-ai-hallucinations-into-lessons-in-critical-thinking-ce98819539dc

- RAG Avancé : Le Guide de l’Optimisation – webjeje.eu, consulté le décembre 3, 2025, https://webjeje.eu/rag-avance-le-guide-de-loptimisation/

- Maturity Matrix — A Tool for Objective Decision-Making | by Joaquim Quiroga | Medium, consulté le décembre 3, 2025, https://medium.com/@joaquim.quiroga/maturity-matrix-a-tool-for-objective-decision-making-4c1bfea9533e

- webjeje.eu, consulté le décembre 3, 2025, https://webjeje.eu/

- The State of AI in Education 2025 – Carnegie Learning, consulté le décembre 3, 2025, https://discover.carnegielearning.com/hubfs/PDFs/Whitepaper%20and%20Guide%20PDFs/2025-AI-in-Ed-Report.pdf?hsLang=en

- LLM Inference Enhanced by External Knowledge: A Survey – arXiv, consulté le décembre 3, 2025, https://arxiv.org/html/2505.24377v1

- Hallucinations in Large Language Models for Education: Challenges and Mitigation, consulté le décembre 3, 2025, https://ijtle.com/public/img/uploads/file/pdf/2IJTLE-1020510-Hallucinations.pdf

- From Superficial Outputs to Superficial Learning: Risks of Large Language Models in Education – arXiv, consulté le décembre 3, 2025, https://arxiv.org/html/2509.21972v1

- (PDF) When Code Begins to Dream: Anthropomorphism in AI Powered Educational Tools, consulté le décembre 3, 2025, https://www.researchgate.net/publication/394978172_When_Code_Begins_to_Dream_Anthropomorphism_in_AI_Powered_Educational_Tools

- Toward Reasonable Parrots: Why Large Language Models Should Argue with Us by Design, consulté le décembre 3, 2025, https://arxiv.org/html/2505.05298v1

- Mitigating Hallucinations in LLMs for Community College Classrooms: Strategies to Ensure Reliable and Trustworthy AI-Powered Learning Tools – Faculty Focus, consulté le décembre 3, 2025, https://www.facultyfocus.com/articles/teaching-with-technology-articles/mitigating-hallucinations-in-llms-for-community-college-classrooms-strategies-to-ensure-reliable-and-trustworthy-ai-powered-learning-tools/

- The Double-Edged Sword of Anthropomorphism in LLMs – MDPI, consulté le décembre 3, 2025, https://www.mdpi.com/2504-3900/114/1/4

- Artificial Intelligence and the Future of Teaching and Learning (PDF) – Department of Education, consulté le décembre 3, 2025, https://www.ed.gov/sites/ed/files/documents/ai-report/ai-report.pdf

- GenAI From a Literacy Lens: Research on Teaching Texts with Tech | Division of Information Technology, consulté le décembre 3, 2025, https://doit.txst.edu/.assets/division-of-information-technology/documents/2025-ai-symposium/Armstrong%20GenAI%20From%20a%20Literacy%20Lens%20Mahdavivand%20and%20Armstrong

- Early research themes for teaching about AI – My College, consulté le décembre 3, 2025, https://my.chartered.college/impact_article/early-research-themes-for-teaching-about-ai/

- When AI Gets It Wrong: Addressing AI Hallucinations and Bias, consulté le décembre 3, 2025, https://mitsloanedtech.mit.edu/ai/basics/addressing-ai-hallucinations-and-bias/

- The grass is not always greener: Teacher vs. GPT-assisted written corrective feedback, consulté le décembre 3, 2025, https://www.researchgate.net/publication/385398678_The_grass_is_not_always_greener_Teacher_vs_GPT-assisted_written_corrective_feedback

- Je-LKS – Journal of e-Learning and Knowledge Society, consulté le décembre 3, 2025, https://www.je-lks.org/ojs/index.php/Je-LKS_EN/article/download/1567/1035/

- Engaging and Instructing with AI’s Errors: A Cross-Curricular Approach to Critically Examining AI’s Output – Faculty Resources for Educational Excellence – East Central College, consulté le décembre 3, 2025, https://www.eastcentral.edu/free/ai-faculty-resources/engaging-ai-errors/

- AI Literacy and Critical Thinking Self-Assessment Rubric, consulté le décembre 3, 2025, https://ucalgary.ca/live-uc-ucalgary-site/sites/default/files/teams/23/AI%20Handouts/AI%20Literacy/AI-literacy-and-critical-thinking-self-assessment-rubric.pdf

- AI and Critical Thinking in Education | Teaching and Learning | Western Michigan University, consulté le décembre 3, 2025, https://wmich.edu/x/teaching-learning/teaching-resources/ai-critical-thinking

- Bias in AI – Teaching Writing Across the Curriculum with AI, consulté le décembre 3, 2025, https://teachingwacwithai.tracigardner.com/category/ai-concept/bias-in-ai/

- 6.1 Teaching About (the Risks of) AI – Generative AI Guidebook for Teaching & Learning at Conestoga – Open Library Publishing Platform, consulté le décembre 3, 2025, https://ecampusontario.pressbooks.pub/conestogagenaiguidebook/chapter/6-1-risks/

- Testing and Assessment | University of Michigan-Flint Generative AI, consulté le décembre 3, 2025, https://www.umflint.edu/genai/assignments-in-the-ai-era/testing-and-assessment/

- The Revolution Has Arrived: What the Current State of Large Language Models in Education Implies for the Future – arXiv, consulté le décembre 3, 2025, https://arxiv.org/html/2507.02180v1

- RAG For Educational Application | PDF | Artificial Intelligence – Scribd, consulté le décembre 3, 2025, https://www.scribd.com/document/897610174/4-RAG-for-Educational-Application

- 8 RAG Architecture Diagrams You Need to Master in 2025 – Software Development Hub, consulté le décembre 3, 2025, https://sdh.global/blog/development/8-rag-architecture-diagrams-you-need-to-master-in-2025/

- consulté le janvier 1, 1970, https://webjeje.eu/prompt-engineering-modelisation-des-4-niveaux-de-maturite-et-definition-du-point-dequilibre-operationnel/

- ️Assistant GPT – Préparation à l’épreuve orale 3 du CAPEPS – webjeje.eu, consulté le décembre 3, 2025, https://webjeje.eu/assistant-gpt-preparation-a-lepreuve-orale-3-du-capes-eps/

- When LLMs day dream: Hallucinations and how to prevent them – Red Hat, consulté le décembre 3, 2025, https://www.redhat.com/en/blog/when-llms-day-dream-hallucinations-how-prevent-them

- Human-in-the-Loop Agentic Systems Explained | by Tahir | Medium, consulté le décembre 3, 2025, https://medium.com/@tahirbalarabe2/human-in-the-loop-agentic-systems-explained-db9805dbaa86

- Oversee a prior art search AI agent with human-in-the-loop by using LangGraph and watsonx.ai – IBM, consulté le décembre 3, 2025, https://www.ibm.com/think/tutorials/human-in-the-loop-ai-agent-langraph-watsonx-ai

- Evolving Human-in-the-Loop: Building Trustworthy AI in an Autonomous Future – Seekr, consulté le décembre 3, 2025, https://www.seekr.com/blog/human-in-the-loop-in-an-autonomous-future/