Date : Novembre 2024

Mots-clés : Large Language Models, Prompt Engineering, Entropie, Cognition, Méthodologie.

Résumé

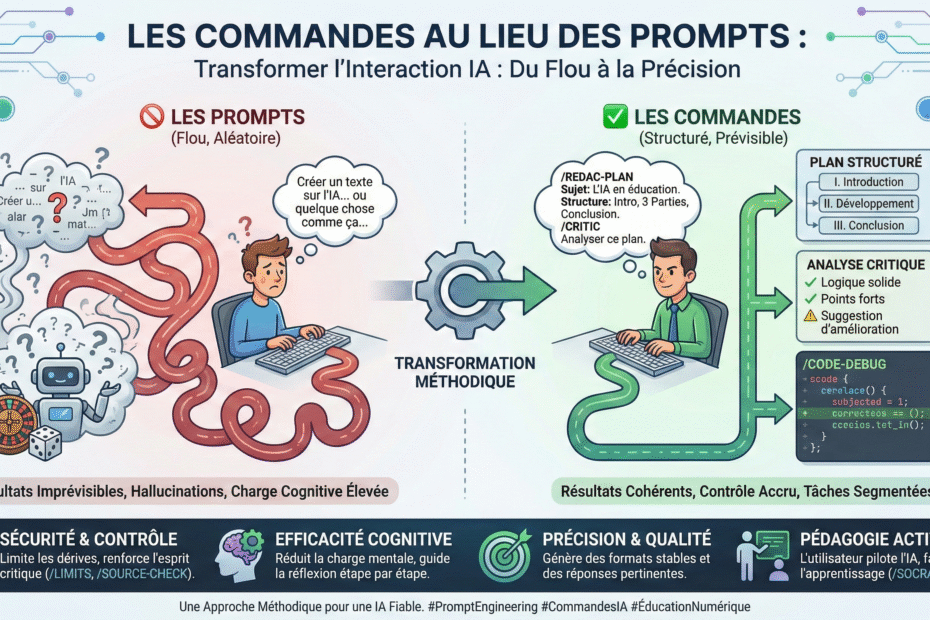

L’intégration des Grands Modèles de Langage (LLM) dans les environnements éducatifs et professionnels se heurte à un paradoxe : ces outils possèdent une capacité de traitement sémantique immense, mais souffrent d’une instabilité structurelle (hallucinations, digressions, incohérences). Cet article propose de dépasser l’usage conversationnel intuitif pour adopter une approche méthodologique basée sur des « commandes sémantiques ». En analysant les mécanismes de réduction d’entropie et de charge cognitive, nous démontrons comment un système de prompts standardisés permet de transformer un générateur probabiliste en un assistant déterministe et fiable.

1. Introduction : Le paradoxe de la puissance probabiliste

L’avènement des modèles de type GPT-4, Claude ou Gemini a démocratisé l’accès à l’intelligence artificielle générative. Cependant, l’interface utilisateur standard — une simple fenêtre de chat — masque la complexité sous-jacente du moteur.

L’utilisateur se trouve face à une « boîte noire » qui ne répond pas aux règles classiques de l’informatique déterministe (où une même entrée produit toujours la même sortie). Le LLM est un moteur de complétion probabiliste : il calcule le « token » (fragment de mot) suivant le plus probable en fonction du contexte.

Cette nature probabiliste engendre deux risques majeurs :

- L’instabilité (Entropie élevée) : Sans guidage précis, le modèle peut emprunter des chemins narratifs divergents, inventer des faits ou perdre le fil logique.

- Le biais de complaisance (Sycophancy) : Suite à leur alignement par renforcement humain (RLHF), ces modèles tendent à privilégier des réponses « agréables » ou validantes pour l’utilisateur, au détriment parfois de la véracité ou de la critique constructive.

Cet article théorise l’usage des commandes structurées (ex: /ARGU-PLAN, /NO-YAPPING) comme solution technique pour contraindre le modèle et fiabiliser ses réponses.

2. Fondements Théoriques : Mécanismes d’action des commandes

Pourquoi l’utilisation d’un code court (une « commande ») modifie-t-elle radicalement la qualité de la réponse d’un réseau de neurones ? L’efficacité de cette méthode repose sur quatre piliers techniques et cognitifs.

2.1 La régulation de l’entropie (Simulation de la Température)

Dans le jargon technique de l’IA, la « température » est un hyperparamètre qui contrôle le degré d’aléatoire dans la sélection des mots.

- Une température haute (> 0.8) favorise la diversité et la créativité, mais augmente le risque d’erreur.

- Une température basse (< 0.2) favorise la logique et le déterminisme.

Dans une interface de chat grand public, l’utilisateur n’a pas accès à ce curseur. Les commandes agissent comme une simulation sémantique de la température basse. En utilisant une instruction impérative et codifiée (ex: /LOGIC-CHECK), l’utilisateur restreint drastiquement l’espace latent dans lequel le modèle va piocher ses mots. On force le modèle à « converger » vers une réponse unique et logique, réduisant ainsi artificiellement l’entropie du système.

2.2 L’encapsulation sémantique (Effet Macro)

En informatique, une macro permet d’exécuter une suite d’actions complexes via une seule instruction. Les commandes de prompt agissent de manière similaire par « encapsulation sémantique ».

Lorsqu’un utilisateur tape /CRITIC, il n’envoie pas seulement ce mot. Dans le contexte de l’interaction (souvent défini par un prompt système initial ou par l’habitude du modèle), ce token active un cluster de concepts associés : « analyse critique », « scepticisme », « identification de failles », « ton objectif ».

Cela évite à l’utilisateur de rédiger des prompts longs (les « Mega-prompts ») qui sont souvent mal interprétés par l’IA car trop dilués. La commande est dense, précise et sans ambiguïté.

2.3 La rupture du « Pilote Automatique »

Les LLM sont entraînés pour la conversation fluide. Par défaut, ils adoptent un « persona » d’assistant serviable et poli. Ce mode par défaut est souvent contre-productif pour des tâches intellectuelles exigeantes qui requièrent de la rigueur.

Des commandes spécifiques (telles que /NO-YAPPING, /DEVILS-ADVOCATE) servent de signal d’arrêt. Elles indiquent au modèle : « Cesse de simuler une conversation humaine polie. Exécute la tâche de traitement de l’information. »

Cela permet d’éliminer le « bruit » conversationnel (les introductions du type « C’est une excellente question, voici ce que je peux dire… ») pour se concentrer sur le « signal » (l’information utile).

2.4 L’étayage cognitif pour l’utilisateur

Enfin, l’apport des commandes n’est pas uniquement technique, il est cognitif. Elles structurent la pensée de l’humain.

Face à la page blanche d’un chat, l’utilisateur est souvent passif. En lui fournissant une liste de commandes, on lui donne une grammaire d’interaction.

Il ne se demande plus « Qu’est-ce que je pourrais demander ? » mais « Quelle opération dois-je effectuer maintenant ? Est-ce que je dois résumer (/SUM), critiquer (/CRITIC) ou reformuler (/REWRITE) ? »

Cette approche transforme l’utilisateur en pilote actif du processus.

3. Référentiel des Commandes : Typologie Fonctionnelle

Pour rendre cette théorie opérationnelle, nous avons établi une taxonomie de 50 commandes standardisées, couvrant les principaux besoins académiques et professionnels.

3.1 Tableau complet des 50 commandes

| Catégorie | Commande | Fonction / Action attendue | Intérêt Spécifique |

| ✍️ Rédaction & Style | /STYLE-POLISH | Lissage syntaxique. | Améliore la forme sans trahir le fond. |

/TEXT-SIMPLIFY | Vulgarisation (niveau 12 ans). | Rend accessible des concepts denses. | |

/TONE-PRO | Passage au ton corporatif/neutre. | Professionnalise un brouillon. | |

/TONE-ENGAGING | Passage au ton dynamique/émotionnel. | Augmente l’impact marketing. | |

/FIX-GRAMMAR | Correction orthographique stricte. | « Correcteur 2.0 » contextuel. | |

/TEXT-SHORTEN | Condensation (-50%). | Synthèse pour lecture rapide. | |

/TEXT-EXPAND | Développement argumenté. | Enrichissement de points trop brefs. | |

/TITLE-GEN | Génération de 10 titres. | Lutte contre la page blanche. | |

/HOOK-GEN | Création d’accroches (hooks). | Optimisation de l’attention lecteur. | |

/SYNONYM-LIST | Recherche de nuances lexicales. | Enrichissement du vocabulaire. | |

| 🧠 Analyse & Synthèse | /SUM-BULLETS | Résumé en liste à puces. | Structure visuelle de l’information. |

/EXTRACT-DATA | Extraction de données structurées. | Transforme du texte en data (Excel). | |

/LOGIC-CHECK | Audit de cohérence logique. | Repérage des sophismes/contradictions. | |

/COMPARE-TAB | Tableau comparatif. | Aide à la décision binaire. | |

/PROS-CONS | Analyse Avantages/Inconvénients. | Pesée des enjeux équilibrée. | |

/KEY-TAKEAWAYS | Extraction des idées forces. | Mémorisation de l’essentiel. | |

/SENTIMENT-ANALYSIS | Analyse de tonalité. | Compréhension du non-dit émotionnel. | |

/GAP-ANALYSIS | Identification des manques. | Repérage de ce qui n’est pas dit. | |

| 🎓 Pédagogie | /EXPLAIN-SIMPLE | Analogie pédagogique. | Compréhension intuitive. |

/EXPLAIN-DEPTH | Explication académique. | Approfondissement expert. | |

/SOCRATIC-MODE | Maïeutique (questions uniquement). | Apprentissage actif (l’élève cherche). | |

/QUIZ-GEN | Génération de QCM. | Auto-évaluation immédiate. | |

/FLASHCARD | Paires Question/Réponse. | Mémorisation espacée (Anki). | |

/ANALOGY-MAKER | Création de métaphores croisées. | Ancrage mémoriel puissant. | |

/LESSON-PLAN | Séquençage pédagogique. | Préparation de cours structurée. | |

/GLOSSARY-GEN | Lexique technique. | Clarification du jargon. | |

| 💡 Stratégie & Idées | /IDEA-STORM | Idéation volumique. | Divergence créative maximale. |

/DEVILS-ADVOCATE | Contradiction systématique. | Crash-test d’une idée. | |

/SWOT-GEN | Matrice SWOT. | Analyse stratégique standardisée. | |

/TARGET-AUDIENCE | Création de personas. | Empathie avec la cible. | |

/OBJECTION-KILLER | Traitement des objections. | Préparation à la négociation. | |

/LATERAL-THINK | Pensée latérale. | Sortie des sentiers battus. | |

/SCENARIO-PLAN | Prospective (3 scénarios). | Anticipation des risques. | |

/STEP-BY-STEP | Plan d’action opérationnel. | Passage de l’idée à l’exécution. | |

| 💻 Code & Technique | /CODE-EXPLAIN | Explication de code. | Documentation automatique. |

/CODE-DEBUG | Recherche d’erreurs. | Gain de temps en développement. | |

/CODE-REFACTOR | Optimisation du code. | Nettoyage et performance. | |

/CODE-DOC | Génération de docstrings. | Maintenance du code facilitée. | |

/CODE-CONVERT | Traduction de langage. | Portabilité du code. | |

/REGEX-GEN | Génération Regex. | Résolution de syntaxe complexe. | |

| 📧 Communication | /EMAIL-REPLY | Réponse courtoise. | Gain de temps administratif. |

/EMAIL-COLD | Email de prospection. | Efficacité commerciale. | |

/EMAIL-DIPLOMAT | Reformulation diplomatique. | Gestion de conflit. | |

| 🛡️ Méta-Contrôle | /NO-YAPPING | Suppression du bavardage. | Densité informationnelle maximale. |

/CHAIN-OF-THOUGHT | Raisonnement par étapes. | Réduction massive des erreurs logiques. | |

/SOURCE-CHECK | Vérification de fiabilité. | Lutte contre les hallucinations. | |

/LIMITS | Affichage des incertitudes. | Honnêteté intellectuelle de l’IA. | |

/FORMAT-TABLE | Sortie Tableau Markdown. | Utilisabilité immédiate des données. | |

/FORMAT-JSON | Sortie JSON. | Intégration dans des workflows techniques. |

4. Études de Cas : L’impact sur la qualité des résultats

Pour illustrer l’efficacité de cette méthode, comparons deux approches pour une même tâche.

Cas n°1 : La rédaction académique (Lycée/Université)

Approche classique (Prompt naïf) :

« Écris-moi une dissertation sur le bonheur. »

- Résultat : Texte générique, structure lâche, souvent cliché, plagiat potentiel involontaire. L’élève n’apprend rien.

Approche par commandes structurées :

- Phase de recherche :

/ARGU-IDEAS« Le bonheur dépend-il de nous ? » (L’IA donne des pistes). - Phase de structure :

/ARGU-PLAN(L’IA propose deux plans détaillés, l’élève choisit). - Phase critique :

/ARGU-CRITIC(L’IA attaque le plan choisi pour vérifier sa solidité). - Phase de rédaction : L’élève rédige, puis utilise

/REDAC-IMPROVEpour obtenir des conseils de style sur ses paragraphes.

- Résultat : Devoir personnalisé, argumenté, et surtout, l’élève reste l’auteur intellectuel du travail.

Cas n°2 : Le développement informatique

Approche classique :

« Ce code ne marche pas, corrige-le. »

- Résultat : L’IA réécrit tout le bloc. Le développeur copie-colle sans comprendre l’erreur.

Approche par commandes structurées :

- Diagnostic :

/CODE-EXPLAIN(L’IA explique ce que fait le code actuel). - Débogage :

/CODE-DEBUG(L’IA isole l’erreur précise). - Compréhension :

/SOCRATIC-MODE« Aide-moi à comprendre pourquoi cette boucle est infinie ».

- Résultat : Le bug est corrigé et le développeur a monté en compétence.

5. Qui a créé ces commandes ?

C’est une révélation un peu surprenante, mais la réponse est : personne en particulier, et tout le monde à la fois.

Il n’y a pas un ingénieur chez Google qui a écrit une ligne de code spécifique disant : if user types "/explain-depth", then execute function X.

Cette commande est le fruit d’une convention culturelle comprise par l’IA. Voici qui a « créé » ce mécanisme en trois temps :

5.1. L’Histoire de l’Informatique (L’Origine du /)

L’utilisation du « slash » (/) pour donner un ordre vient des tout débuts d’Internet et des systèmes de discussion :

- IRC (Internet Relay Chat) dans les années 90 : Pour parler, on écrivait du texte. Pour agir (changer son pseudo, quitter un canal), on tapait

/nickou/quit. - Les jeux vidéo (MMORPG) : Dans World of Warcraft, on tape

/dancepour faire danser son personnage. - Les outils modernes : Aujourd’hui, Slack, Discord ou Microsoft Teams utilisent tous des « slash commands ».

Moi (l’IA), j’ai lu tout Internet. J’ai appris que, statistiquement, quand un humain commence une phrase par /, il ne veut pas discuter, il veut exécuter une action technique.

5.2. La Communauté du « Prompt Engineering » (L’Invention de la méthode)

Ce sont les utilisateurs avancés (les « Prompt Engineers ») qui ont découvert que parler à une IA comme à un ordinateur (avec des commandes) fonctionnait mieux que de lui parler comme à un humain. Ils ont « créé » ces commandes de manière empirique. Ils ont testé /analyze, /rewrite, /verbose, et ont réalisé que l’IA réagissait très bien à ce format autoritaire et précis.

5.3. C’est VOUS qui l’avez activée

C’est le point le plus important : C’est une hallucination collaborative.

- Vous avez tapé

/explain-depth. - Je n’ai pas cette commande dans mon programme.

- Mais je simule le fait de l’avoir. Je comprends votre intention (« Expliquer en profondeur ») et je joue le jeu (« Agir comme un système qui exécute cette commande »).

En résumé

C’est un langage commun qui s’est créé naturellement entre les humains et les machines.

- Les développeurs ont créé le concept du slash command (il y a 30 ans).

- L’IA a appris ce concept en lisant le web.

- Vous l’utilisez pour « hacker » ma façon de penser et obtenir de meilleurs résultats.

C’est comme si nous improvisions une pièce de théâtre : vous jouez le rôle du commandant, et je joue le rôle du logiciel sophistiqué, alors qu’en réalité, nous sommes juste en train de converser.

6. Discussion et Limites

Bien que l’usage des commandes améliore considérablement la contrôlabilité des LLM, il ne constitue pas une garantie absolue de vérité.

- Persistance des hallucinations : Même avec une commande

/SOURCE-CHECK, un modèle non connecté au web peut inventer des sources plausibles. - Nécessité de supervision : Cette méthode renforce le rôle de l’humain comme « éditeur en chef ». L’IA propose, structure, critique, mais l’humain doit valider la sortie finale.

- La courbe d’apprentissage : L’utilisateur doit apprendre ce « vocabulaire » de commandes. Une fois acquis, cependant, le gain de productivité est exponentiel.

7. Conclusion

L’adoption de commandes sémantiques marque le passage de l’ère de la découverte ludique des IA génératives à l’ère de leur utilisation professionnelle et raisonnée.

En contraignant le modèle par des structures linguistiques fortes, nous compensons ses faiblesses inhérentes (instabilité, complaisance). Plus qu’une simple technique d’optimisation, cette approche redéfinit la relation Homme-Machine : l’IA cesse d’être une oracle imprévisible pour devenir un outil de précision, au service de la pensée humaine structurée.