Pour Guitar hero uniquement…

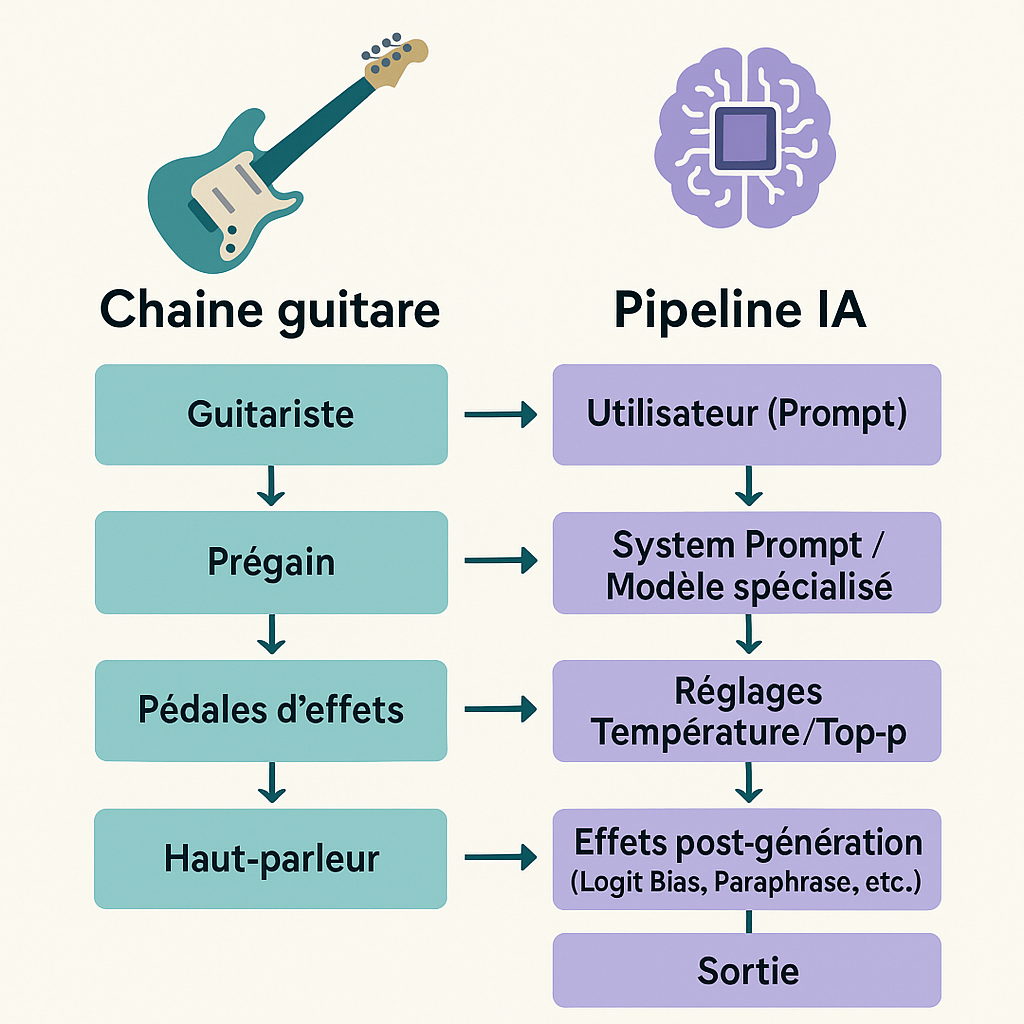

Imaginez une salle de classe transformée en studio de musique : l’enseignant est aux commandes d’une guitare électrique branchée sur un amplificateur. De la même manière qu’un musicien module son son avec divers réglages, un utilisateur d’IA générative peut ajuster plusieurs paramètres fondamentaux pour « amplifier » la créativité ou la précision des réponses de l’IA. Cette analogie entre intelligence artificielle générative et amplificateur de guitare électrique n’est pas qu’une fantaisie : elle offre une grille de lecture concrète pour comprendre des notions techniques comme la consigne système, la température, le top-p, le fine-tuning, le RAG ou encore le logit bias. Nous allons explorer ces concepts à travers la métaphore musicale afin de démystifier le fonctionnement de l’IA générative pour les enseignants et étudiants en sciences de l’éducation.

En branchant une guitare électrique sur un ampli, même un débutant peut produire des sons impressionnants, jouer avec la distorsion en montant le gain, ajuster les graves/aigus via l’égaliseur, ou ajouter des effets pour enrichir le résultat. L’IA générative offre une facilité similaire : en quelques secondes, on génère un texte élaboré ou une image saisissante à partir d’un simple prompt (commande textuelle), là où il aurait fallu des heures de travail manuel. En ce sens, l’IA est au créateur ce que la guitare électrique est au guitariste débutant. Elle amplifie la créativité, ouvre des horizons inédits, mais peut aussi masquer un manque de maîtrise réelle. Comme le note Sam Borms, « de nombreux outputs générés, bien que saisissants au premier regard, peuvent agir comme un écran de fumée cachant l’absence de compétence, un peu à la manière des effets de guitare dissimulant les lacunes techniques du musicien. » Cette réflexion résonne tout particulièrement en contexte éducatif : un élève peut présenter un devoir très abouti produit par IA sans avoir acquis les connaissances sous-jacentes – tout comme un guitariste débutant peut épater la galerie avec du feedback et des pédales d’effet sans savoir jouer un morceau correctement.

Notre objectif est double. D’une part, expliquer de façon vivante les paramètres clés de l’IA générative en les comparant aux éléments d’un ampli de guitare. D’autre part, montrer les implications pédagogiques concrètes de ces réglages dans l’enseignement : comment le professeur peut s’en servir pour augmenter l’efficience de son enseignement, tout en évitant les écueils d’un usage non maîtrisé. Car la technologie, comme le rappelle le chercheur Kentaro Toyama, ne fait qu’amplifier les intentions et compétences préexistantes : « si les agents du changement conçoivent correctement une innovation, la technologie amplifiera leurs efforts ; s’ils se trompent, la technologie amplifiera leurs erreurs. » Autrement dit, un outil puissant comme l’IA peut renforcer une bonne pédagogie – ou accentuer ses dérives – selon l’usage qu’on en fait.

Après avoir posé l’analogie générale, nous passerons en revue chaque paramètre de l’IA comme si vous tourniez les boutons de votre amplificateur. Du réglage initial (consigne système) au filtrage des sorties (top-p, logit bias), en passant par la gestion de la créativité (température), la personnalisation du « son » du modèle (fine-tuning) ou l’ajout de connaissances externes (RAG), chaque section dessinera un parallèle clair entre le musicien pédagogue et le prompt engineer. Enfin, nous dégagerons des bonnes pratiques pédagogiques tirées de cette métaphore, afin que le lecteur puisse concrètement appliquer ces idées en classe – avec, en prime, un petit clin d’œil au domaine de l’EPS pour rappeler que l’enseignement est aussi question de dosage et d’entraînement.

La consigne système : choisir le style et le contexte (le « preset » de l’ampli)

Avant même de commencer à jouer, un guitariste choisit le type d’amplificateur ou de preset qui va définir son son de base : ampli jazz à son clair, stack rock à distorsion puissante, ou encore ajout d’une réverbération d’ambiance. En IA générative, ce rôle est tenu par la consigne système (ou system prompt). La consigne système est un message initial, généralement invisible pour l’utilisateur final, qui fournit des instructions globales au modèle sur son identité, son style et les règles à suivre. C’est comme définir l’« ambiance » de départ de l’ampli. Par exemple, dire à l’IA « Tu es un tuteur de sciences patient et pédagogue » revient à sélectionner un canal clair, propice à un jeu doux et explicatif, tandis que « Tu es un débatteur pointilleux » pourrait s’apparenter à enclencher un mode plus agressif, riche en harmoniques argumentatives.

Techniquement, la consigne système est incluse au début de chaque conversation, avant même la requête de l’utilisateur. On peut y spécifier : le rôle de l’assistant, sa personnalité, le ton attendu, des consignes de formatage, voire fournir des données de contexte qui serviront de base de connaissance. Par exemple, une consigne système peut comprendre des règles du genre « reste toujours poli et utilise un langage adapté à des élèves de collège », ou « si l’utilisateur pose une question historique, réponds en citant des dates précises ». Cela calibre le modèle un peu comme un musicien règle dès le départ son ampli sur un certain profil sonore. Un bon réglage de consigne système est crucial pour obtenir un comportement d’IA cohérent avec les objectifs pédagogiques. Un enseignant qui configure un agent conversationnel scolaire prendra soin d’indiquer en consigne système les règles du jeu (par ex. « n’apporte pas directement la solution, mais guide par des indices », ou « parle en français simple, niveau A2 ») de sorte que l’IA respecte l’intention éducative tout au long de l’échange.

L’analogie musicale peut être poussée plus loin. La consigne système agit comme un réglage d’usine de l’IA : c’est la sonorité de base sur laquelle viendront se greffer tous les autres effets. Tout comme les amplis modernes offrent des modélisations (clean, crunch, lead, acoustique…) qui prédéterminent la couleur sonore, la consigne système pose un cadre qui influence chaque réponse subséquente. Si elle est bien choisie, l’IA « jouera dans la bonne tonalité » dès le départ. À l’inverse, une consigne système inadéquate, floue ou contradictoire revient à démarrer avec un ampli mal configuré : on se battra ensuite avec les réglages pour corriger la direction, au risque d’obtenir du larsen (feedback) ou des réponses hors sujet.

Exemple pédagogique concret : Un enseignant de langues peut définir la consigne système de son chatbot éducatif ainsi : « Tu es un assistant d’anglais qui communique uniquement en anglais, corrige les erreurs de l’élève avec bienveillance et fournit des explications grammaticales simples en français en cas de besoin. » De cette façon, toutes les réponses seront teintées de cette orientation bilingue et bienveillante, sans que l’enseignant ait à le rappeler à chaque question. L’IA adopte le “ton” souhaité comme un ampli bien réglé qui délivre d’emblée le son voulu.

Le prompt de l’utilisateur : les notes jouées sur la guitare

Si la consigne système est l’atmosphère générale de l’ampli, la question ou requête de l’utilisateur est l’équivalent des notes ou accords que le guitariste joue. La guitare (c’est-à-dire l’utilisateur) envoie un signal – quelques phrases, une consigne précise – et l’amplificateur (l’IA) va traiter ce signal en fonction de son réglage préalable pour produire le son final, à savoir la réponse générée. On comprend ici que la qualité du jeu influence le rendu final : un prompt clair et précis, comme un riff bien exécuté, donnera un meilleur résultat qu’un grattage brouillon sur les cordes. L’art de formuler de bonnes requêtes (prompt engineering) revient à bien jouer sa partition afin que l’IA amplifie les bonnes idées et non le bruit.

La métaphore souligne un aspect pédagogique important : il faut apprendre aux élèves à « bien jouer de l’IA », c’est-à-dire à poser de bonnes questions. Un même amplificateur peut rendre un solo sublime ou une cacophonie stridente selon ce qu’on lui injecte. De même, un outil d’IA conversationnelle pourra fournir une réponse confuse à une question vague, et au contraire une réponse pertinente et structurée à une question bien conçue. L’enseignant doit donc entraîner ses apprenants à formuler correctement leurs demandes à l’IA (développer leur littératie prompt), de la même façon qu’on entraîne un musicien à jouer juste et en rythme.

Illustration : demandez à ChatGPT « Parle-moi de l’histoire » vs « Donne-moi un résumé de 5 lignes de la Révolution française, en insistant sur les causes économiques. ». Dans le second cas, le prompt bien ciblé (notes précises) orientera clairement la réponse (son amplifié) vers le contenu souhaité. En somme, consigne système + prompt utilisateur = preset de l’ampli + notes jouées : les deux agissent de concert pour aboutir à la performance finale.

Température : du son sage au solo endiablé (maîtriser la distorsion créative)

Parmi les réglages de l’amplificateur d’IA, la température est sans doute le plus souvent comparé au bouton de gain ou de distorsion d’un ampli guitare. En langage technique, la température est un paramètre qui module la part de hasard dans la génération du texte. Concrètement, elle ajuste la forme de la distribution de probabilité des prochains mots : plus la température est élevée (>1), plus la distribution est aplatie, permettant au modèle de sélectionner des tokens moins probables, donc de produire un texte créatif et imprévisible. À l’inverse, une température basse (<1) concentre la probabilité sur les tokens les plus probables, rendant la sortie plus conservatrice, répétable et déterministe.

Transposons cela à la musique : un faible gain sur l’ampli donne un son clair, sans saturation, où chaque note est conforme et prévisible – on pourrait parler d’un jeu « sage ». C’est l’équivalent d’une température basse : l’IA se contente des réponses les plus attendues, sans fioritures ni digressions. En revanche, quand on monte le gain sur un ampli, le son se distord, se rempli d’harmoniques imprévues, le jeu devient plus audacieux, chaotique, voire carrément expérimental si on pousse le potentiomètre à fond. De même, une température élevée donnera des réponses d’IA variées, originales, parfois délirantes, car le modèle osera prendre des chemins moins probables dans la phrase. Pour filer la métaphore, la température de l’IA, c’est un peu le degré de saturation artistique que vous appliquez au discours de la machine.

Dans la pratique éducative, connaître ce réglage est capital. Si votre objectif est d’obtenir une réponse exacte à une question de cours, mieux vaut baisser la température (typiquement autour de 0,2–0,5) pour encourager le modèle à rester factuel et cohérent. Par exemple, pour résoudre un problème de mathématiques étape par étape, une température basse réduira le risque d’élucubrations farfelues et limitera les variations d’une exécution à l’autre. On cherche ici un son clair et net, sans distorsion – l’IA doit jouer la partition telle qu’écrite, sans improviser. En revanche, si vous lancez un brainstorming créatif en classe de littérature (imaginons que les élèves sollicitent ChatGPT pour trouver des idées d’histoires fantastiques), augmenter la température (0,7 ou 0,8, voire 1) permettra d’obtenir des propositions plus diversifiées, inattendues, potentiellement inspirantes. C’est comme encourager le guitariste à faire un solo improvisé en plein morceau – cela peut déboucher sur des trouvailles géniales, mais aussi sur quelques fausses notes.

Il faut cependant avertir que trop de température peut nuire : au-delà d’un certain seuil, le texte généré peut devenir incohérent, partir dans des digressions incontrôlées ou répéter du charabia. L’équivalent acoustique serait une distorsion extrême qui rendrait le son brouillon et méconnaissable – en somme, du larsen pédagogique. À l’inverse, une température trop proche de 0 fige complètement le modèle dans ses réponses les plus probables, pouvant donner une impression de répétition ou de manque de souffle créatif (un peu comme un guitariste qui rejouerait machinalement les mêmes accords sans aucune variation). Trouver le bon dosage est un art : commencez par les réglages par défaut (souvent Température = 1.0) puis ajustez graduellement selon les besoins.

Résumé analogique : Température = réglage de la “prise de risque” sonore. Basse température : son propre, maîtrisé, pas de surprise (idéal pour les exposés factuels, les consignes strictes). Haute température : son expérimental, saturé de créativité (idéal pour la génération d’idées, les exercices d’imagination). L’éducateur est ici comparable à un ingénieur du son qui sait quand ajouter du gain pour stimuler la créativité de ses élèves, et quand le réduire pour garder les réponses de l’IA fiables et pédagogiquement exploitables.

Top-p : un filtre intelligent pour éviter les fausses notes

Le paramètre top-p, également appelé nucleus sampling (échantillonnage par noyau de probabilité), est un autre contrôle de la diversité de sortie du modèle. Il fonctionne différemment de la température : au lieu d’agir sur la forme de la distribution globale, il limite dynamiquement le vocabulaire parmi lequel l’IA peut choisir à chaque étape. Plus précisément, le top-p définit un seuil de probabilité cumulative : le modèle ne considérera que la plus petite liste de tokens (mots potentiels) dont la probabilité cumulée atteint p (par exemple 0,9 ou 0,95), et il ignorera tous les tokens en dehors de ce “noyau”. Ainsi, avec top-p = 0,9, on ne garde que les mots les plus probables jusqu’à couvrir 90% de probabilité totale, écartant les candidats les plus improbables même si la température les a rendus éligibles. En quelque sorte, top-p agit comme un garde-fou qui empêche l’IA de s’égarer sur des choix trop exotiques.

L’analogie musicale : imaginons un guitariste qui connaît une large gamme de notes mais qui décide de ne jouer qu’un sous-ensemble de ces notes couvrant l’essentiel de la mélodie. C’est un peu comme restreindre son jeu aux notes les plus harmonieuses dans la tonalité choisie, en évitant les notes dissonantes qui gâcheraient l’ensemble. Le top-p = 0,9 équivaut à dire : “ne joue que les notes qui s’intègrent dans 90% des cas dans ce style, laisse de côté les 10% de notes les plus étranges ou risquées.” On obtient ainsi une improvisation contrôlée : suffisamment de diversité pour ne pas tourner en rond, mais pas au point de produire des sons incongrus. Techniquement, top-p offre une limitation dynamique du vocabulaire : si le modèle est très confiant (une seule suite plausible), le noyau sera petit ; s’il est incertain (plusieurs suites possibles proches), le noyau s’élargira en conséquence. On peut voir là l’analogue d’un musicien qui élargit sa palette de notes seulement lorsque la situation (l’harmonie du morceau) le permet, et non de façon arbitraire.

Dans l’usage pratique, top-p est souvent combiné avec ou utilisé à la place de la température pour peaufiner la créativité de l’IA. Par exemple, en paramétrant température = 1.0 mais top-p = 0.9, on autorise le modèle à être imaginatif tout en lui interdisant de partir sur des mots trop rares ou inappropriés contextuellement. Cela peut être utile en éducation pour générer du contenu qui reste sur le sujet. Supposons que vous demandiez à l’IA d’écrire une courte histoire pour enfants sur les fractions mathématiques. Une température élevée donnera des idées originales, mais le top-p pourra éviter que l’histoire ne devienne soudainement trop farfelue ou hors sujet en éliminant les choix de mots trop improbables (par exemple un terme scientifique très compliqué, ou un personnage incongru) si leur probabilité cumulative est en dehors du seuil. Le résultat : un bon équilibre entre cohérence et créativité, un peu comme un morceau de musique qui expérimente sans perdre son fil mélodique.

En bref, Top-p = tri sélectif des notes. C’est un filtre intelligent qui garantit que l’essentiel du sens est couvert avant de permettre des extravagances. Avec un top-p faible (ex : 0,5), le modèle sera extrêmement prudent et ne piochera que dans les mots les plus probables (au risque de se répéter ou d’être un peu terne). Avec un top-p trop proche de 1.0, on revient quasiment à ne pas filtrer du tout – l’IA pourrait alors ressortir des bizarreries si la température est élevée. La valeur typique de 0,9–0,95 est souvent recommandée pour un bon compromis entre diversité et pertinence. Pour l’enseignant, cela signifie qu’il peut accorder son ampli IA de sorte que la machine n’émette pas de “fausses notes” logiques ou d’idées trop farfelues, surtout lors d’activités où une structure narrative ou argumentative doit rester solide.

(Note : il existe un paramètre cousin, top-k, qui limite non pas par probabilité cumulative mais en ne gardant que les k tokens les plus probables, quels que soient leurs poids. Top-k est un filtre quantitatif (ex : ne considérer que les 50 options les plus probables) tandis que top-p est qualitatif (considérer toutes les options jusqu’à atteindre p% de probabilité). Top-k et top-p se rejoignent dans l’idée de restreindre la palette de l’IA pour éviter les aberrations. Dans notre métaphore, top-k serait comme dire « n’utilise pas plus de k accords différents dans ton improvisation », indépendamment de leur probabilité, alors que top-p dit « utilise autant d’accords que nécessaire pour couvrir l’essentiel du morceau ». Nous nous concentrons sur top-p car c’est un réglage courant dans les interfaces grand public comme ChatGPT, souvent préféré à top-k pour sa souplesse.)

Fine-tuning : un instrument accordé sur mesure

Quand un musicien souhaite adapter sa guitare à un style particulier, il peut procéder à un réaccordage fin de son instrument, changer de cordes, modifier l’électronique, voire opter pour un modèle spécial. De même, quand on veut adapter un modèle d’IA générique à un cas d’usage très spécifique, on utilise le fine-tuning (affinage du modèle). Le fine-tuning est une technique qui spécialise un modèle de langue pré-entraîné sur une tâche ou un domaine particulier en ajustant ses poids à l’aide de nouvelles données. En d’autres termes, au lieu d’utiliser l’IA en mode “généraliste” tel quel, on lui fait apprendre des exemples supplémentaires propres à notre contexte pour qu’elle devienne experte de ce contexte.

Dans notre analogie, le fine-tuning correspondrait à modifier l’amplificateur ou la guitare elle-même pour un usage dédié. Par exemple, un guitariste de métal pourra changer les micros de sa guitare pour des humbuckers haut gain, utiliser un ampli à lampes Marshall et accorder son instrument un ton plus bas : il personnalise son matériel pour obtenir le son métal caractéristique. De même, un chercheur ou enseignant peut fine-tuner un modèle de langage général (disons GPT-3 ou Llama-2) avec des corpus propres à sa discipline pour obtenir un modèle affiné, qui « sonne juste » sur ses questions de cours. On peut imaginer un fine-tuning sur des centaines de problèmes de physique corrigés pour qu’un assistant d’IA excelle à résoudre des exercices de mécanique du bac, ou encore un fine-tuning sur les œuvres du réalisme du XIXe siècle pour qu’un chatbot littéraire adopte le style et le savoir adéquats pour discuter de Balzac et Flaubert.

Techniquement, le fine-tuning consiste à réentraîner légèrement le modèle sur un ensemble de données spécialisées, en partant d’un modèle pré-entraîné très performant. On ajuste ainsi certains paramètres internes (poids synaptiques du réseau de neurones) sans repartir de zéro, ce qui permet au modèle de conserver ses connaissances générales tout en apprenant des connaissances spécifiques nouvelles. C’est comme partir d’un guitariste qui sait déjà jouer de tout, et lui faire pratiquer intensivement du flamenco pendant un mois : il n’oubliera pas la guitare classique, mais il aura acquis des techniques propres au flamenco qu’il réutilisera dès que le contexte s’y prête. En ce sens, le fine-tuning est à mi-chemin entre l’apprentissage global (pré-entraînement de l’IA sur des milliards de mots, comparable à un musicien qui apprend tous les styles) et la simple configuration (prompt engineering, comparable au réglage des boutons sans changer l’instrument). On change quelques cordes et on réaccorde l’IA pour qu’elle performe de manière optimale dans le registre souhaité.

Pour les enseignants, le fine-tuning ouvre des perspectives passionnantes. Imaginons une université qui crée son propre modèle de langage fine-tuné sur des manuels scolaires, des supports de cours et des devoirs corrigés : l’IA ainsi obtenue pourrait être un tuteur expert dans le curriculum maison, répondant aux questions des étudiants avec une précision et un vocabulaire alignés sur le programme. De fait, ce type de spécialisation de l’IA est déjà à l’étude dans le secteur éducatif. Toutefois, il faut noter que le fine-tuning nécessite des ressources (données bien choisies, puissance de calcul) et un cadre éthique (on entraîne l’IA sur du contenu potentiellement protégé ou sensible, il faut donc maîtriser ce processus).

L’analogie de l’ampli rappelle aussi une chose : fine-tuner un modèle, c’est un peu construire son propre ampli boutique au lieu d’acheter un ampli standard du commerce. On obtient exactement le son désiré, mais cela demande du savoir-faire. Pour beaucoup d’enseignants, la solution alternative plus accessible sera le paramétrage par prompts et l’utilisation de techniques comme le RAG (voir section suivante), qui ne nécessitent pas de toucher aux « câblages internes » de l’IA. Néanmoins, il est bon de comprendre que derrière chaque IA éducative performante se cache potentiellement un fine-tuning soigné : un modèle ajusté pour coller au niveau des apprenants, à la langue cible, au référentiel éducatif local, etc. On peut dire que le fine-tuning, c’est “accorder” l’IA au diapason de sa classe – un luxe technique encore réservé aux initiés, mais dont l’importance grandit à mesure que les outils se démocratisent.

(À noter : des méthodes de fine-tuning léger, comme l’apprentissage par renforcement avec retour humain (RLHF) ou l’utilisation de Low-Rank Adaptation (LoRA) sont des variantes techniques permettant d’ajuster un modèle de façon plus efficiente. Sans entrer dans le détail, retenons que l’idée générale reste de partir d’un modèle général et de le spécialiser sans perdre ses acquis initiaux. Un parallèle musical serait les présets d’ampli partagés : on prend un son de base et on applique un patch pour le transformer en un son signature sans tout refabriquer.)

RAG (Retrieval-Augmented Generation) : brancher l’ampli à une encyclopédie externe

Jouer de la guitare seul peut être gratifiant, mais parfois le musicien a besoin d’une partition, d’une backing track ou d’un looper pour enrichir sa performance. De même, un modèle de langage fonctionnant seul sur sa connaissance interne peut produire des réponses impressionnantes, mais il lui arrive de manquer d’informations à jour ou précises sur un sujet donné. C’est là qu’intervient la technique du RAG (Retrieval-Augmented Generation), qu’on peut traduire par génération augmentée par recherche. Le RAG consiste à connecter le modèle d’IA à une source de connaissances externe pour qu’il aille y puiser des informations avant de formuler sa réponse.

Poussons l’analogie : c’est comme brancher votre amplificateur sur un pédalier d’effets qui contient une banque de morceaux ou d’samples, ou encore glisser au guitariste des feuillets de tabs (tablatures) en temps réel pendant qu’il improvise. Soudain, il ne se repose plus uniquement sur sa mémoire musicale, il a accès à un répertoire élargi qui lui permet de jouer la bonne mélodie au bon moment. Pour l’IA, cela veut dire : avant de répondre, elle effectue une recherche dans une base documentaire (par exemple Wikipédia, des articles scientifiques, un cours en PDF, etc.), puis elle incorpore les éléments trouvés pertinents dans sa réponse. L’amplificateur IA n’est plus isolé, il est connecté à un énorme corpus de référence, comme un ampli relié à un juke-box de connaissances.

L’un des intérêts majeurs du RAG, notamment en éducation, est de réduire les “hallucinations” du modèle. En effet, un modèle de langage standard, s’il ne sait pas quelque chose, peut avoir tendance à l’inventer avec aplomb (par exemple donner une fausse date historique plausible mais erronée). C’est un problème bien connu de confiance dans les chatbots éducatifs. Avec le RAG, l’IA est incitée à s’appuyer sur des sources factuelles plutôt que sur sa seule “imagination”. Elle devient capable de citer un manuel scolaire ou un article de recherche pour étayer sa réponse, un peu comme un élève bien formé qui irait chercher dans son livre la formule physique exacte au lieu de la deviner. Des études soulignent que le RAG « surmonte la barrière principale à l’adoption des chatbots à base de LLM en éducation : les hallucinations », et qu’avec une architecture relativement simple on peut ainsi implémenter des chatbots spécialisés pour divers besoins des élèves et enseignants.

Concrètement, comment cela fonctionne-t-il ? On peut résumer le processus RAG en trois étapes :

- Indexer la connaissance externe : on prépare une base de documents utiles (cours, documentation, wiki interne…) convertie en un format interrogeable (souvent via des embeddings et un index vectoriel, mais retenons juste qu’il y a une “bibliothèque” consultable rapidement par l’IA).

- Recherche pertinente : à chaque requête utilisateur, on extrait les mots-clés ou l’essence de la question et on lance une recherche dans cette base pour trouver les documents les plus pertinents. Par exemple, si l’élève demande « Qu’est-ce que le théorème de Noether ? », le système RAG va chercher dans la bibliothèque de cours de maths/physique s’il y a une section sur Noether.

- Augmentation de prompt : on prend les extraits de documents trouvés et on les insère dans le prompt envoyé au modèle de langage, typiquement sous la forme « D’après les documents suivants [extraits] réponds à la question… ». Le modèle génère alors sa réponse en tenant compte de ces informations fraîches, un peu comme un guitariste intègre dans son solo des bribes de mélodies qu’il vient de lire sur une partition.

Le résultat ? Une réponse plus pertinente, précise et ancrée dans du concret, avec éventuellement la possibilité de fournir la source (référence du document) comme gage de fiabilité. Pour l’éducation, c’est un changement de jeu : on peut envisager des assistants qui répondent aux questions des élèves en citant exactement le manuel de l’élève ou le cours du professeur vu en classe, éliminant ainsi le décalage entre le discours de l’IA et le contenu pédagogique officiel. De plus, le RAG permet de mettre à jour les connaissances d’un modèle sans le réentraîner : si un fait nouveau apparaît (par exemple une avancée scientifique), on peut l’ajouter dans la base documentaire et l’IA le consultera au besoin, contournant ainsi la limite de « date de connaissance » figée de son entraînement. C’est un peu comme brancher l’ampli sur la radio en direct : le musicien IA peut jamer avec les dernières nouvelles du monde.

Du point de vue de l’instrumentiste : le RAG élargit l’orchestre. Plutôt que d’être un solo de guitare, l’IA devient un groupe où la guitare (modèle de base) joue en harmonie avec une basse et une batterie fournies par la base documentaire. L’enseignant peut tirer profit du RAG en alimentant son assistant virtuel avec les supports de cours, les consignes précises des travaux, voire les manuels officiels. Ainsi, quand un élève posera une question, la réponse de l’IA sera pertinente et référencée : « Selon le cours du chapitre 3, la réponse est… ». On a alors un assistant pédagogique qui ne se contente plus d’amplifier une prompt, mais qui s’appuie sur la bonne partition pour jouer la mélodie adéquate.

Logit bias : l’égaliseur qui module la tonalité de sortie

Dans le monde de la musique amplifiée, il est courant d’user d’égaliseurs (EQ) pour renforcer ou atténuer certaines fréquences. Un réglage de basses rehaussé donnera un son plus rond et grave ; couper les aigus élimine un sifflement indésirable, etc. De manière analogue, l’IA dispose d’un réglage avancé nommé logit bias qui permet de favoriser ou pénaliser certains mots (tokens) dans les choix du modèle. C’est un outil plus technique, souvent absent des interfaces grand public mais présent dans les API, qui agit en coulisses sur les « logits » (les scores bruts avant le tirage du prochain mot). En simplifiant, on peut dire que le logit bias dit au modèle “augmente ou diminue la probabilité de tel mot”, un peu comme un DJ pousserait le volume d’une fréquence sur sa table de mixage.

Imaginez un amplifier équipé d’un filtre qui empêcherait certaines notes de sortir de l’enceinte, ou au contraire qui amplifierait spécialement un certain motif chaque fois qu’il est joué. Par exemple, un égaliseur paramétrique qui désactive complètement la plage de fréquences correspondant à un larsen (feedback) gênant revient à bannir un élément sonore. De même, via le logit bias, on peut interdire formellement certains tokens dans la réponse de l’IA en leur assignant un biais très négatif (par exemple -100), ce qui les rend quasiment impossibles à sélectionner. On utilise cela pour éviter des mots offensants, des réponses sensibles ou des fuites d’informations interdites. C’est comme dire à l’ampli : « ne joue jamais cette note désagréable ». À l’inverse, on peut encourager l’usage d’un mot ou d’un style en mettant un biais positif sur certains tokens, ce qui les rend plus enclins à apparaître. Par analogie, on demanderait au musicien : « mets en valeur telle phrase musicale chaque fois que possible ».

Dans le contexte éducatif, le logit bias peut s’avérer utile pour calibrer finement la voix de l’IA. Par exemple, si l’on crée un assistant conversationnel pour des enfants, on pourrait imposer un bias négatif sur des mots vulgaires ou trop compliqués, s’assurant qu’ils ne figurent pas dans le vocabulaire généré. Inversement, on pourrait encourager certains termes techniques du programme scolaire pour être sûr qu’ils soient utilisés régulièrement (et ainsi familiariser l’élève avec). Imaginons un tuteur d’histoire qui devrait toujours employer le mot « République » plutôt que « gouvernement » lorsqu’il parle de la France post-1792 : un léger biais positif sur République guidera le modèle vers ce choix lexical. On peut voir cela comme accorder la “couleur tonale” de l’IA – telle une pédale d’égalisation qui assure que le timbre global reste conforme à l’attendu.

Cependant, le logit bias est à manier avec précaution. Trop forcer le modèle, c’est comme pousser un égaliseur à l’extrême : on risque de dénaturer complètement le son. Si l’on interdit trop de mots, le modèle peut devenir incohérent ou tourner en rond faute de synonymes autorisés. Si l’on survalorise un mot, on peut obtenir un tic de langage où l’IA le répète de façon artificielle. Cet outil, très puissant, est un peu l’arme secrète de l’ingénieur du prompt avancé : on l’utilisera principalement pour éviter des dérapages (par exemple bannir absolument toute mention d’une réponse hors-sujet ou d’un indice pendant un quiz) ou pour imposer un style très particulier.

Pour illustrer, OpenAI donne l’exemple d’utiliser le logit bias pour « banaliser » le ton d’un assistant de support client en encourageant des mots neutres comme “comprendre”, “assister”, “résoudre” afin de maintenir un registre calme et poli. C’est un peu comme pré-régler l’IA sur une station de radio “soft jazz” pour l’ambiance : le logit bias assure que la sortie reste dans cette ambiance en modulant les éléments lexicaux clés.

En résumé, Logit bias = égalisation ciblée du langage. Dans notre métaphore, c’est le dernier étage du rack d’effets, le petit égaliseur 10 bandes qui permet d’affiner le son final produit par l’IA. Pour un enseignant, connaître son existence c’est comprendre qu’il est possible, au-delà du choix du prompt (notes jouées) et des réglages globaux (température, top-p, etc.), de sculpter très précisément certains aspects de la réponse de l’IA. C’est sans doute le moins intuitif des paramètres présentés ici, mais il complète notre palette en montrant qu’on peut vraiment traiter l’IA comme un instrument modulable jusqu’au choix du moindre mot.

Enjeux et implications pédagogiques : jouer juste avec l’amplificateur d’IA en classe

À travers cette analogie musicale, une idée centrale se dégage : utiliser l’IA générative en éducation demande une forme de “virtuosité” pédagogique. Tout comme un bon guitariste sait quel effet activer pour quel passage d’un morceau, un bon enseignant doit apprendre à régler les paramètres de l’IA en fonction de l’activité d’apprentissage visée. Passons en revue quelques implications concrètes et bonnes pratiques que l’on peut retenir, telles des leçons de notre jam session IA/guitare :

- Connaître son instrument pour éviter les abus : Un prof d’EPS vous le dira, il faut doser l’effort. De même, en IA, doser la créativité est crucial. Utilisez une température basse pour les tâches d’évaluation ou de restitution de connaissances, où l’on attend de la rigueur et des réponses fiables (ex: correction d’exercices, définition d’un concept scientifique). Augmentez la température pour les activités de créativité ou de réflexion ouverte, où l’on veut stimuler l’imagination de l’élève (ex: proposer des sujets d’écriture, brainstorming de projets). Pensez-y comme l’effort physique en EPS : parfois on fait des exercices cadrés (endurance fondamentale, mouvements techniques précis) et parfois des ateliers ludiques plus libres – mais on ne mélange pas tout sans préparation.

- Structurer le contexte comme on règle sa scène : Avant de lancer l’IA en interaction avec les élèves, définissez toujours une consigne système claire. En contexte scolaire, cela revient à préciser le rôle de l’IA et le type d’aide qu’elle apporte. Par exemple : « Tu es un assistant pédagogique qui aide l’élève en lui posant des questions de compréhension de texte », ou « Tu es un personnage historien du XIXᵉ siècle qui raconte la Révolution industrielle ». Cette mise en scène initiale guide l’IA comme la configuration d’un ampli guide le son du concert. Les enseignants ayant expérimenté ChatGPT notent que définir un cadre (ton de voix, niveau de langage attendu, étapes du raisonnement, etc.) améliore nettement la qualité des échanges et évite des réponses hors sujet ou inadaptées.

- Personnaliser l’IA à son public : Si possible, alimenter l’IA avec du matériel de cours réel. Sans même aller jusqu’au fine-tuning complet, on peut utiliser la technique du RAG plus simplement via des prompts contextuels. Par exemple, copier-coller dans la consigne système un extrait du cours en lien avec le sujet avant de poser la question à l’IA. Cela agit déjà comme un mini-RAG manuel et augmente la pertinence des réponses. Sur le long terme, des établissements pourront déployer des chatbots connectés à la base de connaissances de la médiathèque ou aux archives de la classe virtuelle, de façon transparente. Les premiers retours de terrain sont positifs, montrant une diminution des erreurs factuelles (hallucinations) lorsque l’IA est contrainte de s’appuyer sur un contenu donné. Pour l’élève, cela signifie aussi apprendre à vérifier les sources que l’IA mentionne : on développe ainsi l’esprit critique, compétence essentielle dans un monde saturé d’informations.

- Gardez la main sur la “volume principal” : Dans un concert, l’ingénieur du son surveille toujours le volume général pour éviter les dérapages. En contexte d’apprentissage, le professeur reste maître du jeu. Cela signifie qu’il faut surveiller et encadrer l’utilisation de l’IA par les élèves, fixer des limites claires (par ex. « pour ce devoir, vous pouvez demander des explications à l’IA mais pas lui faire rédiger le texte final »). L’analogie de l’amplificateur rappelle que pousser le volume trop fort sans contrôle mène au larsen – de même, laisser l’IA faire tout le travail cognitif sans médiation pédagogique mène à un contournement de l’effort par l’élève et donc à un apprentissage illusoire. Plusieurs enseignants l’ont constaté : les élèves utilisant ChatGPT sans guidance peuvent rendre des copies impeccables en surface mais n’ayant pas assimilé le fond du cours. Il faut donc concevoir des activités où l’IA est un amplificateur de la participation de l’élève, pas un substitut à son travail. Par exemple, l’IA peut générer des pistes de réflexion que l’élève devra trier/justifier, plutôt que de donner directement une réponse à apprendre par cœur.

- Éduquer à la métacognition et à l’esprit critique : Utiliser cette métaphore de l’ampli en classe peut être un moyen didactique en soi. En expliquant aux élèves que l’IA réagit comme un instrument, on peut dédramatiser son aura de « boîte noire magique ». L’élève comprendra qu’en jouant différemment (changeant son prompt) ou en tournant tel bouton (par ex. “essaie avec plus de créativité”), le résultat changera – c’est une invitation à expérimenter et à ne pas prendre le premier output pour vérité gravée dans le marbre. On peut imaginer un atelier en technologie ou en documentation où les élèves s’amusent à faire varier la température ou le style du prompt et constatent l’effet sur la réponse, puis présentent leurs résultats. Cette démarche les transforme en utilisateurs actifs et critiques de l’IA, aptes à comprendre ses limites (tout comme un musicien sait qu’un ampli peut saturer, les élèves réalisent qu’une IA peut délirer si mal paramétrée).

- Améliorer l’efficience de l’enseignement : Sur un plan plus pratique, l’analogie de l’amplification s’applique aussi au rôle même de l’enseignant face à ces outils. Beaucoup décrivent l’IA générative comme un multiplicateur de forces dans la préparation de supports pédagogiques. Un enseignant bien formé peut, grâce à ChatGPT, générer en quelques minutes une banque de 50 questions de révision variées là où il lui aurait fallu une heure, ou encore obtenir un script de code pour une simulation en physique qu’il n’aurait pas su écrire seul. L’IA, bien utilisée, peut amplifier la productivité pédagogique, ce qui rejoint la notion de technologie-amplificateur mentionnée plus haut. Attention toutefois : amplifier la productivité ne veut pas dire sacrifier la qualité ou le discernement. Tout contenu généré doit être relu, validé et éventuellement corrigé par l’humain. C’est comme si l’IA vous donnait un « premier jet amplifié » – libre à vous ensuite de le moduler, le filtrer, l’éditer pour qu’il corresponde exactement à votre intention pédagogique.

En filigrane de ces implications, on retrouve le rôle essentiel de l’enseignant en tant que chef d’orchestre. La technologie n’enlève rien à la nécessité d’une démarche pédagogique solide, elle la rend même plus cruciale. Comme le note le formateur Olivier Sidokpohou, les enseignants doivent « se saisir des opportunités pour améliorer l’efficience du système éducatif, former les élèves à l’utilisation de l’IA, tout en développant l’esprit critique pour un usage raisonné ». C’est exactement l’enjeu de savoir quand et comment tourner chaque bouton de notre amplificateur d’IA.

Et puisque nous avions promis un clin d’œil à l’EPS : on peut dire qu’entraîner ses élèves avec l’IA, c’est un peu comme un circuit training. On alterne des phases intenses (recherche d’idées créatives – température haute) et des phases de récupération structurée (synthèse de notions clés – température basse). On ajuste l’« intensité cognitive » comme un coach dose l’effort physique. Le professeur, tel un coach sportif du numérique, veille à ce que chacun progresse en utilisant l’outil sans se blesser intellectuellement (en perdant son esprit critique ou le goût de l’effort). Le mot d’ordre est le même sur le terrain de sport et dans la classe augmentée par l’IA : personnalisation, progressivité, et plaisir d’apprendre.

Conclusion

Au terme de cette exploration, l’analogie entre IA générative et amplificateur de guitare électrique s’est révélée particulièrement féconde pour appréhender les rouages de ces nouvelles technologies dans un contexte éducatif. Nous avons vu que les paramètres techniques – consigne système, température, top-p, fine-tuning, RAG, logit bias – ne sont pas de froides notions réservées aux informaticiens, mais peuvent être compris intuitivement en les comparant à des boutons, effets et techniques musicales. Cette métaphore musicale a un but clair : redonner à l’enseignant et à l’apprenant le contrôle et la compréhension de l’outil d’IA, tout comme un musicien comprend et maîtrise son ampli pour en tirer le meilleur son.

Un amplificateur, par nature, prend un signal modeste et le porte à un niveau supérieur. L’IA générative, si on la considère comme un amplificateur cognitif, peut de même porter nos idées, nos questions, nos savoirs à une échelle démultipliée. Entre des mains expertes, elle permettra à un élève de vivre des expériences d’apprentissage plus riches, d’explorer des pistes qu’il n’aurait pas imaginées seul, ou de recevoir une aide individualisée quasi instantanée. Mais n’oublions pas le revers : un ampli mal réglé peut couvrir les fausses notes de l’instrumentiste, donnant l’illusion d’une maîtrise qui n’y est pas. De même, une IA peut fournir du prêt-à-penser séduisant qui cache des lacunes chez l’élève ou la paresse d’aller au bout d’un raisonnement. Le rôle de l’éducateur est alors d’enseigner à “bien jouer” de l’IA, de valoriser le travail en profondeur et l’acquisition des compétences, au-delà du vernis de la performance immédiate.

En définitive, tant que nous conserverons cet équilibre – accueillir l’ampli numérique comme un moyen d’enrichir la musique de l’éducation, sans jamais renoncer à jouer nous-mêmes de notre instrument – nous pourrons être optimistes. Comme dans un groupe de musique, il y a de la place pour l’acoustique et l’électrique, pour le solo de guitare virtuose et pour l’appui subtil des effets en arrière-plan. L’IA n’est ni une menace qui remplace le musicien, ni une baguette magique supprimant l’apprentissage : c’est un outil amplificateur qui, bien utilisé, peut faire résonner l’enseignement plus loin et plus fort, au service de chaque apprenant. À nous, enseignants, formateurs, étudiants, de devenir les musiciens avertis de cette symphonie techno-pédagogique. Comme le disait en substance le groupe Funkadelic cité par Sam Borms, « Rien n’est bon à moins d’en jouer ». Alors n’hésitons pas à jouer, expérimenter, et innover avec ces amplificateurs d’intelligence : la scène éducative de demain n’en sera que plus vibrante.

Bibliographie / Sitographie

- Sam Borms (2025). An Analogy Between AI and Guitars. Medium. (Analogie entre l’IA générative et la guitare électrique, explorant comment l’IA permet de créer rapidement des outputs impressionnants tout en posant la question de la maîtrise réelle).

- Andrii Chornyi (2024). Understanding Temperature, Top-k, and Top-p Sampling in Generative Models. Codefinity Blog. (Article expliquant les paramètres de réglage de la génération de texte, notamment la température – contrôle du caractère aléatoire – et l’échantillonnage Top-p dit « nucléus »).

- Raphaël Kassel (2024). Fine-Tuning : Qu’est-ce que c’est ? À quoi ça sert en IA ? Datascientest.com. (Introduction en français au concept de fine-tuning des modèles de machine learning, définissant le fine-tuning comme la spécialisation d’un modèle pré-entraîné sur une tâche spécifique).

- AWS (2025). What is Retrieval-Augmented Generation (RAG)? Amazon Web Services – AI Explained. (Page explicative d’AWS sur la technique du RAG, définissant le RAG comme le fait de référencer une base de connaissance externe avant de générer la réponse pour améliorer la pertinence et l’actualité des réponses des LLM).

- Swacha et al. (2023). Retrieval-Augmented Generation (RAG) Chatbots for Education: A Survey of Applications. Applied Sciences, 15(8), 4234. (Article de recherche passant en revue les usages des chatbots à génération augmentée par recherche dans l’éducation, notant que le RAG surmonte le problème des hallucinations des LLM et peut être implémenté pour divers besoins éducatifs spécifiques).

- Vellum AI (2023). What is Logit Bias and how to use it. vellum.ai LLM Parameter Guide. (Guide décrivant le paramètre logit_bias, qui permet de rendre un modèle plus ou moins susceptible de générer certains mots en modifiant la probabilité de sélection de tokens spécifiques).

- Dane de l’académie de Strasbourg (2024). L’IA générative dans l’éducation : défis et opportunités pour les enseignants. (Article d’analyse institutionnelle sur l’arrivée des IA génératives à l’école, évoquant entre autres le besoin pour les enseignants de s’adapter, de former les élèves à l’IA et d’encadrer les usages pour maintenir l’effort cognitif).

- Marc Prensky (2015). Technology as an “Amplifier”. Educational Technology, Sept-Oct 2015. (Article discutant la thèse de Kentaro Toyama selon laquelle la technologie agit comme amplificateur des intentions humaines : une bonne pratique éducative sera amplifiée par la technologie, tandis qu’une mauvaise sera aggravée).