Introduction : Démystifier l’« éthique intrinsèque » des IA génératives

Les progrès fulgurants des Large Language Models (LLM) – modèles d’intelligence artificielle générative capables de produire du texte cohérent comme ChatGPT – ont suscité autant d’enthousiasme que d’inquiétudes. Dans le débat public, on entend souvent dire que ces modèles ne seraient « pas éthiques par essence ». En d’autres termes, certains attribuent au modèle lui-même une forme de moralité (ou d’immoralité) intrinsèque. Cette perception repose sur plusieurs idées reçues : les LLM seraient inévitablement biaisés et discriminatoires, incontrôlables dans leurs productions (allant jusqu’à « halluciner » des informations), ou encore incapables de respecter le droit d’auteur.

Or, considérer un modèle comme « éthique » ou « non éthique » en soi est trompeur. « La technologie n’est ni bonne, ni mauvaise. Une technologie est neutre. C’est l’utilisation qu’on en fait qui peut être qualifiée d’éthique ou de non éthique », rappelle à juste titre un expert en finance à propos de l’IA. De même, le co-créateur de Siri Luc Julia souligne qu’il ne faut pas anthropomorphiser ces systèmes : « L’une des idées reçues les plus répandues est de les assimiler à des humains, alors qu’elles ne font qu’imiter nos biais. Et plus on s’attend à ce qu’elles soient omnipotentes, plus la déception est grande ».

Dans cet article, nous réfutons de façon argumentée et pédagogique l’idée qu’un LLM serait « non éthique par essence ». À travers plusieurs chapitres, chacun centré sur une idée reçue courante, nous déconstruisons ces arguments en mobilisant des références françaises et internationales, des comparaisons avec d’autres technologies du quotidien, ainsi que des exemples concrets. Notre objectif est de montrer que la question de l’éthique se pose non pas au niveau du modèle seul, mais à travers la conception, les données, l’interface et surtout l’usage qui en est fait, ainsi qu’au niveau de la régulation entourant ces outils.

Idée reçue : « Les modèles sont biaisés, donc non éthiques. »

Des biais hérités des données, reflets de nos préjugés humains

Il est indéniable que les modèles d’IA générative apprennent à partir de données massives issues du monde réel, données qui peuvent contenir des biais (stéréotypes de genre, préjugés raciaux, etc.). Un LLM entraîné sur l’ensemble du web héritera en partie des biais et inégalités de la société. Par exemple, une étude a montré que demander à une IA de générer des images sur « les tâches ménagères » produit majoritairement des femmes, tandis que des termes liés à l’entreprise font apparaître davantage d’hommes blancs. De même, un célèbre cas d’école est celui d’un algorithme de recrutement entraîné sur dix ans de CV : il a été constaté qu’il discriminait les candidatures féminines, simplement parce qu’il apprenait d’historiques où les recrues étaient majoritairement des hommes. Ces dérives illustrent un risque réel : des décisions automatisées injustes ou des contenus générés stéréotypés pouvant causer un préjudice.

Faut-il en conclure que le modèle est « non éthique » par nature ? Pas exactement. Ce sont d’abord les données et les contextes qui sont biaisés. Un adage bien connu en informatique, « garbage in, garbage out », résume la situation : des données biaisées en entrée pervertissent les résultats du modèle (IA : les armes de Google et Facebook pour faire la chasse aux biais). En d’autres termes, le LLM reflète la société telle qu’elle est, avec ses inégalités, plutôt qu’il ne décide de lui-même d’être injuste. « Les biais sont inévitables. Plutôt que de chercher à les éliminer totalement, il faut les comprendre et les assumer », explique Luc Julia. En effet, « tant qu’un modèle est générique, il est biaisé, car il reflète la nature même d’Internet, qui est lui-même biaisé ». Il rappelle par exemple qu’environ 70 % du contenu en ligne provient des États-Unis, ce qui oriente les références culturelles d’un modèle généraliste dans un sens majoritairement nord-américain. En Europe, on pourrait entraîner un modèle sur des données locales pour le rendre plus conforme à nos valeurs ; mais cela donnerait seulement « l’illusion d’un système plus éthique, car il repose sur des données que nous contrôlons et considérons comme légitimes. En réalité, cela ne fait qu’introduire nos propres biais dans le système ». Autrement dit, aucun modèle n’est neutre, tout comme aucun ensemble de données humaines n’est parfaitement neutre.

Cette inévitabilité des biais ne signifie pas qu’il faut l’ignorer, bien au contraire. Cela signifie qu’il faut agir à d’autres niveaux pour garantir l’équité : intervenir sur les données, l’architecture et le paramétrage du modèle, ainsi que sur son usage. Des entreprises travaillent sur l’amélioration de leurs données et algorithmes pour réduire les biais. Facebook, par exemple, a mis au point un outil interne (“Fairness Flow”) pour détecter et corriger les résultats discriminatoires de ses modèles de machine learning (IA : les armes de Google et Facebook pour faire la chasse aux biais). De plus, la diversité des équipes de développement joue un rôle : « Des équipes diversifiées […] sont bien plus à même de repérer ces biais grâce à leur propre expérience ». En matière de LLM, OpenAI et d’autres ont recours à l’apprentissage par renforcement avec retour humain (RLHF) afin d’aligner le modèle sur des valeurs éthiques : concrètement, des annotateurs humains ont orienté ChatGPT pour qu’il refuse les injures, qu’il évite les propos discriminants, etc. L’IA n’est pas spontanément morale, mais on peut la régler pour qu’elle suive des consignes éthiques. C’est un travail d’ingénierie et d’encadrement, qui relève de la responsabilité des concepteurs.

Pour mieux comprendre, comparons avec des technologies du quotidien. Un moteur de recherche comme Google ou Qwant peut, en fonction des requêtes, faire remonter des contenus problématiques. Par exemple, une recherche mal intentionnée peut conduire à des sites haineux ou complotistes. Faut-il en déduire que le moteur de recherche en lui-même est “non éthique” ? Bien sûr que non : l’algorithme indexe le web tel qu’il existe. La question de l’éthique se pose plutôt dans la façon dont l’outil est conçu (ex : Google travaille à déréférencer les sites les plus toxiques) et utilisé par l’internaute. De même, un logiciel comme Word ou Excel n’a pas d’éthique propre : un utilisateur peut très bien y rédiger un texte discriminatoire ou réaliser des calculs malhonnêtes. Ce ne sera pas la faute du logiciel ; l’éthique intervient au niveau de l’utilisateur et de l’usage qu’il fait de l’outil. Il en va de même pour un modèle de langage : il est un outil statistique sophistiqué. S’il produit un contenu biaisé, c’est que les données ou la requête le conduisent dans cette direction.

En somme, pointer les biais d’un LLM est crucial pour améliorer l’outil, mais cela ne suffit pas à le condamner en bloc. Les biais des IA génératives ne sont pas une fatalité morale, mais un problème technique et sociétal à résoudre. Comme le dit la chercheuse Anna Jobin, « il n’y aura jamais de modèle sans aucune erreur et sans aucun biais », car aucun modèle ne peut reproduire fidèlement la complexité totale du réel. Cela n’implique pas d’abandonner ces modèles, mais d’accompagner leur développement par des mesures d’équité (choix des données, diversification des équipes, audits algorithmiques) et par une utilisation critique. L’éthique, ici, consiste à reconnaître l’existence de ces biais et à mettre en place des garde-fous pour les limiter au maximum, plutôt que d’accuser l’outil d’être immoral par essence.

Idée reçue : « On ne sait pas ce qu’ils vont produire ; leurs réponses peuvent être n’importe quoi, ce n’est pas éthique. »

Imprévisibilité et « hallucinations » : un défi technique, pas une malveillance

Une autre critique fréquente envers les IA génératives est leur tendance à produire des réponses imprévisibles, parfois incorrectes ou absurdes, qu’on qualifie poétiquement d’« hallucinations ». En effet, qui n’a pas vu ChatGPT affirmer avec assurance une fausse information ou fournir un raisonnement faux tout en ayant l’air convaincant ? Par exemple, interrogé sur un fait précis qu’il ne connaît pas, le modèle peut inventer une source ou une réponse de toutes pièces. Des utilisateurs ont piégé des LLM en posant des questions insolubles : il a été rapporté que certains modèles proposaient même des démonstrations fallacieuses pour prouver que 2+2 = 5, simplement parce que la question était formulée ainsi. Ces errements, qui peuvent prêter à sourire, posent problème dans des usages sérieux : diagnostics médicaux erronés, conseils financiers inexacts, etc.. D’un point de vue éthique, on s’inquiète de la fiabilité et de la responsabilité de l’IA : comment utiliser un système dont on ne peut pas garantir les sorties ?

Il faut d’abord comprendre pourquoi ces modèles ont de telles limites. Un LLM ne « comprend » pas véritablement le monde ; il ne fait que générer la suite de texte la plus probable selon son entraînement statistique. Si on lui demande une absurdité d’un ton sérieux, il tentera d’y répondre sur le même ton, faute de conscience pour détecter l’absurdité. « L’IA ne comprend pas véritablement ce qu’elle dit ; elle génère des réponses en fonction des modèles statistiques sous-jacents », rappelle Luc Julia. Ainsi, plus un modèle est généraliste et entraîné à tout faire, plus il risque de se tromper hors de son contexte : « plus une IA est généraliste, moins ses retours sont pertinents » note Luc Julia, qui évalue qu’un modèle comme ChatGPT peut donner des réponses justes environ dans 64 % des cas seulement. Cela laisse plus d’un tiers de réponses possiblement incorrectes ou fantaisistes, ce qui est non négligeable.

Cependant, l’imprévisibilité des réponses n’est pas synonyme de malveillance éthique. Un LLM n’a pas l’intention de tromper ; il ne “sait” même pas qu’il peut induire en erreur. Le qualifier d’« immoral » parce qu’il se trompe serait comme accuser un enfant qui apprend de mentir intentionnellement chaque fois qu’il fait une erreur. Ce qui est en jeu, c’est plutôt l’usage indiscriminé de ces modèles sans discernement. L’éthique consiste alors à bien encadrer l’utilisation de l’IA générative, surtout dans les domaines sensibles. Par exemple, OpenAI conseille explicitement de ne pas utiliser ChatGPT comme seule source pour des décisions médicales ou juridiques, mais plutôt comme un assistant sous supervision humaine. De même, l’UNESCO et d’autres organisations préconisent la présence d’un humain dans la boucle (human-in-the-loop) pour vérifier et assumer la responsabilité des décisions lorsque l’IA est utilisée dans l’éducation, la santé, etc.

Par ailleurs, il existe des moyens techniques de réduire fortement l’imprévisibilité des LLM. Les concepteurs disposent de paramètres de génération qu’ils peuvent ajuster : par exemple, la température et le Top-p. La température contrôle le degré de créativité aléatoire du modèle ; une température basse (proche de 0) rend les réponses plus déterministes et conservatrices, tandis qu’une température élevée (vers 1) les rend plus variées et imprévisibles. Pour des contenus où l’exactitude prime, on choisira donc une température faible : « pour des contenus où l’exactitude et la fiabilité sont primordiales […], opter pour une température plus basse est préférable. Cela garantit que l’information générée reste proche des données et des interprétations les plus probables, minimisant le risque de diffuser des informations incorrectes ou trompeuses ». Le paramètre Top-p (ou nucleus sampling) agit de manière complémentaire : il limite la sélection du prochain mot aux X % les plus probables. Un Top-p bas (ex : 0,3) forcera le modèle à ne considérer que les mots les plus attendus, évitant des digressions peu probables, tandis qu’un Top-p plus élevé (ex : 0,9) autorisera plus de diversité lexicale (Temperature, top_p, pénalités de fréquence et de présence : ces paramètres qui influencent ChatGPT) (Temperature, top_p, pénalités de fréquence et de présence : ces paramètres qui influencent ChatGPT). En combinant une température et un Top-p judicieusement choisis, on contrôle fortement la variabilité du texte généré. Les utilisateurs avancés ou développeurs peuvent ainsi configurer un LLM pour qu’il soit plus sûr et focalisé.

En plus des paramètres, une autre pratique de plus en plus courante est l’IA augmentée par recherche (appelée Retrieval-Augmented Generation, RAG). Cette technique consiste à connecter le modèle à une base de connaissances ou à des documents externes : au lieu de s’appuyer uniquement sur ses souvenirs (qui peuvent être lacunaires ou périmés), l’IA va puiser des informations à jour dans une base de données ou sur Internet, puis les intégrer dans sa réponse. On fournit donc au modèle des données de contexte pertinentes avant qu’il ne réponde. Cela améliore notablement la justesse et la vérifiabilité des réponses. Luc Julia souligne que deux approches montantes pour accroître la pertinence des IA sont « le fine-tuning […] et le RAG (Retrieval-Augmented Generation), qui permet d’intégrer des connaissances externes pour améliorer la pertinence des réponses ». Par exemple, une université pourrait utiliser un LLM couplé à son référentiel bibliographique : à chaque question posée, le système récupère les articles scientifiques pertinents et oblige le modèle à s’en inspirer, réduisant ainsi le risque d’hallucination. De même, certaines solutions professionnelles intègrent leurs données maison pour personnaliser l’IA à leur contexte, ce qui la rend plus prévisible et contrôlable.

Enfin, l’interface utilisateur joue un rôle crucial dans le contrôle des sorties du modèle. Les concepteurs d’applications intégrant un LLM peuvent ajouter des filtres de modération pour intercepter des réponses potentiellement malveillantes (haineuses, violentes, etc.) avant qu’elles n’arrivent à l’usager. C’est ce que font les chatbots comme ChatGPT ou Bing : ils ont un module qui vérifie la réponse générée et la censure le cas échéant, fournissant à la place un message d’excuse. Ainsi, même si le modèle brut pourrait produire « n’importe quoi », le système complet dans lequel il s’insère peut être bridé pour empêcher les dérapages connus.

En résumé, le caractère aléatoire et parfois trompeur des LLM n’est pas une question de morale, mais de technique et d’ingénierie de la fiabilité. Il incombe aux développeurs et aux utilisateurs d’être conscients de ces limites et d’adopter les parades nécessaires (réglage des paramètres, filtres, usage de données de référence, validation humaine). Comparativement, un moteur de recherche aussi peut présenter des résultats non pertinents ou choquants si on formule mal sa requête ; cela ne le rend pas « non éthique » en soi. Ce qui compte, c’est la manière dont l’outil est maîtrisé et supervisé. Une IA générative utilisée de façon responsable sera encadrée par des règles (par exemple, un enseignant peut autoriser son usage pour de la recherche d’idées, mais pas pour rendre un devoir sans relecture). L’éthique, ici, réside dans la prise de conscience de la faillibilité de ces modèles et la mise en place d’une utilisation éclairée, transparente quant à leurs limites, plutôt que dans une défiance abstraite envers l’outil lui-même.

Idée reçue : « Les IA génératives ne respectent pas les droits d’auteur. »

Entraînement sur des œuvres protégées : un débat de droit et de pratiques

Une critique très médiatisée à l’égard des LLM concerne le droit d’auteur. En effet, pour entraîner ces modèles, les entreprises ont aspiré des énormes volumes de textes sur internet, incluant potentiellement des œuvres protégées (articles de presse, ouvrages numérisés, code source, etc.) sans consentement explicite des auteurs. De plus, un LLM entraîné sur un corpus donné peut parfois restaurer textuellement des passages entiers de son corpus si on le pousse dans ce retranchement – autrement dit, plagier involontairement des extraits d’œuvres existantes. Par exemple, on pourrait imaginer lui demander de « rédiger un poème à la manière de Victor Hugo » et recevoir en sortie des vers très proches de ceux d’un poème réel de Hugo, violant potentiellement le droit d’auteur. Cette possibilité soulève un problème éthique et légal : l’IA aurait alors reproduit du contenu sans permission, ce qui est assimilable à de la contrefaçon au sens du Code de la propriété intellectuelle. En France, « toute reproduction intégrale ou partielle d’une œuvre sans le consentement de l’auteur est illicite ». Plusieurs procès sont en cours contre OpenAI et d’autres, intentés par des créateurs ou des éditeurs, inquiets que leurs contenus aient servi à entraîner des IA sans compensation ni autorisation (Une IA éthique concurrente de ChatGPT n’empiétant pas sur le droit d’auteur ? Cette start-up française y croit !).

Cela signifie-t-il qu’un modèle de langage est forcément non éthique car « voleur » de données ? Là encore, il faut nuancer et examiner le niveau de responsabilité. D’abord, il est tout à fait possible de développer un LLM sans empiéter sur le droit d’auteur : c’est ce qu’a démontré en 2024 une start-up française, Pleias, en annonçant le modèle Common Corpus. Il s’agit d’un LLM de taille comparable à GPT-3, entraîné exclusivement sur des contenus du domaine public (textes tombés dans le domaine public, données libres de droits, etc.), avec le soutien de laboratoires de recherche et du ministère de la Culture (Une IA éthique concurrente de ChatGPT n’empiétant pas sur le droit d’auteur ? Cette start-up française y croit !). Cette preuve de concept est importante : « il est possible d’entraîner un LLM sans empiéter sur le droit d’auteur » (Une IA éthique concurrente de ChatGPT n’empiétant pas sur le droit d’auteur ? Cette start-up française y croit !). Le fait que des acteurs majeurs aient choisi d’ignorer le cadre du droit d’auteur relève plus d’un choix stratégique (accélérer les progrès en ingérant tout le web) que d’une fatalité technique. D’ailleurs, OpenAI a publiquement justifié sa démarche en estimant que « le seul moyen de développer des IA toujours plus performantes est de cesser de s’embarrasser à respecter des concepts datés comme le copyright », position évidemment contestée (Une IA éthique concurrente de ChatGPT n’empiétant pas sur le droit d’auteur ? Cette start-up française y croit !). On le voit, le débat sur l’entraînement des IA touche à des questions juridiques en évolution (faut-il créer une exception au droit d’auteur pour le text and data mining, dans quelles limites ?) et à des arbitrages entre innovation et respect des droits. Ce débat sociétal dépasse largement la seule existence des modèles : il s’agit de définir quelles données peuvent être utilisées, à quelles conditions, et comment compenser les ayants droit.

Ensuite, sur la question des sorties des modèles (génération de texte ressemblant fortement à une œuvre existante), il est notable que les développeurs intègrent des garde-fous pour éviter cela. Par exemple, ChatGPT est explicitement bridé pour ne pas fournir le texte complet d’œuvres protégées (chansons, extraits littéraires longs, code propriétaire, etc.). Si vous lui demandez les paroles complètes d’une chanson récente, il refusera, évoquant des raisons de droits d’auteur. De même, si un utilisateur mal intentionné utilise un LLM pour produire un document en copiant de larges passages d’un livre, c’est l’utilisateur qui commet l’acte de contrefaçon. Juridiquement, la responsabilité de l’IA en tant qu’entité n’est pas (encore) définie ; ce sont les utilisateurs et éditeurs de ces outils qui peuvent être tenus pour responsables en cas de violation. Par exemple, « la responsabilité de l’utilisateur [d’un LLM] pourrait être engagée y compris en l’absence de connaissance du caractère contrefaisant des contenus », la bonne ou mauvaise foi étant indifférente en matière civile. Cela rappelle qu’il revient à l’humain de faire preuve de discernement dans l’exploitation des résultats de l’IA. Tout comme un moteur de recherche peut être utilisé pour trouver et télécharger illégalement un PDF d’un livre protégé (ce qui n’est pas un usage éthique du moteur), un LLM peut être utilisé pour générer du texte problématique. Dans les deux cas, l’intention et l’usage importent : c’est à l’utilisateur ou au fournisseur du service de veiller au respect du droit.

Heureusement, des solutions techniques et organisationnelles se dessinent pour concilier LLM et propriété intellectuelle. Outre l’utilisation de corpus libres, mentionnée plus haut, on peut citer le développement de licences de données spécifiques. Certaines plateformes proposent déjà des ensembles de données textuelles « nets » de tout contenu protégé, ou dont les auteurs ont donné l’autorisation. On parle aussi d’outils permettant de watermarquer (filigraner) les sorties des IA pour tracer ce qui provient d’un modèle, ce qui faciliterait la détection de plagiat involontaire. Sur le plan légal, l’Union européenne, via la Directive DSM (2019), a instauré des exceptions de text and data mining qui autorisent l’exploration de textes à des fins de recherche ou d’entraînement de modèles, dans certaines limites, à condition de respecter le droit des bases de données et de permettre aux auteurs de s’opposer à l’usage de leurs œuvres (via un simple fichier robots.txt par exemple). Ces évolutions indiquent que le cadre est en train de s’adapter : il ne s’agit pas de jeter l’anathème sur la technologie, mais de définir comment l’utiliser de manière équitable vis-à-vis des créateurs humains.

En définitive, accuser les LLM de « ne pas respecter les droits d’auteur » revient à confondre l’outil et l’usage qui en est fait. Un modèle de langage n’a pas de conscience juridique : il traite toute donnée qu’on lui fournit. Si on lui fournit des données illégales, il produira potentiellement des sorties illégales. La faute initiale est dans la constitution du jeu de données et dans l’absence de garde-fous, ce qui renvoie aux responsabilités humaines : celles des concepteurs (choisir d’entraîner sur des données libres ou obtenir des licences, intégrer des filtres anti-plagiat), et celles des instances de régulation (définir un cadre clair, exiger de la transparence sur les corpus utilisés, etc.). Plutôt que de décréter un modèle « non éthique » en bloc, il est plus constructif de promouvoir des pratiques éthiques de conception et d’utilisation : privilégier les sources ouvertes ou sous licence libre, citer les sources lorsque c’est possible (certaines IA commencent à le faire pour justifier leurs réponses), indemniser les créateurs dont les données ont servi, et éduquer les utilisateurs sur ce qu’ils peuvent ou non faire avec une IA générative.

Recentrer le débat : modèle, données, interface ou usage ? (Schéma récapitulatif)

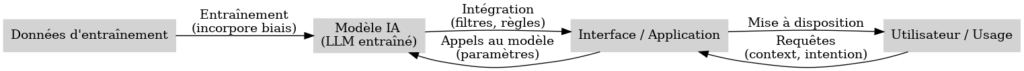

(image) Schéma – Différents niveaux où se joue l’éthique d’un système d’IA générative : les données d’entraînement (qui peuvent être plus ou moins biaisées ou obtenues de manière légitime), le modèle IA en lui-même (algorithme entraîné), l’interface ou application qui l’intègre (avec des réglages, des filtres, une présentation des résultats), et enfin l’utilisateur final et son usage. L’éthique ne réside pas dans le modèle seul, mais dans l’interaction de tous ces niveaux.

À travers les exemples précédents, un constat s’impose : lorsqu’on parle de l’éthique des IA génératives, il faut bien identifier à quel niveau on se place. Très souvent, les problèmes attribués aux modèles eux-mêmes sont en réalité des problèmes de données, de paramétrage ou d’usage. Le schéma ci-dessus illustre les différents maillons de la chaîne d’un système à base de LLM : en amont, les données d’entraînement (conçues par des humains, avec leurs biais et d’éventuelles restrictions juridiques) ; puis le modèle lui-même (les poids mathématiques résultant de l’apprentissage, qui n’ont pas d’intention morale propre) ; ensuite l’application qui utilise le modèle (interface utilisateur, API, programme intégré dans un logiciel, etc., avec ses réglages techniques et son design) ; enfin l’utilisateur et le contexte d’usage. Chacun de ces niveaux pose ses propres questions éthiques :

- Données : Ont-elles été collectées de façon respectueuse des droits et de la vie privée ? Sont-elles représentatives et diversifiées pour éviter les biais ? Par exemple, entraîner un modèle sur des données majoritairement anglophones invisibilisera certaines cultures ; entraîner un modèle sur des données personnelles sans consentement pose un problème de confidentialité. L’éthique « by design » commence donc dès la sélection et la préparation du jeu de données.

- Modèle : L’architecture et les objectifs du modèle jouent aussi un rôle. Par exemple, un modèle conçu pour maximiser l’engagement à tout prix pourrait amplifier des contenus extrêmes (par analogie aux algorithmes de certaines plateformes sociales). Dans le cas des LLM, le modèle en soi est un algorithme d’apprentissage automatique sans conscience ; l’éthique à ce niveau relève plutôt de choix de conception (taille du modèle, consommation énergétique pour l’entraîner, incorporation ou non de mécanismes explicables, etc.). On parle ainsi d’IA durable (réduire l’empreinte carbone de ces très gros modèles) et d’IA explicable (développer des techniques pour expliquer pourquoi le modèle produit telle réponse). Ce sont des considérations éthiques importantes, mais elles ne signifient pas que le modèle a une morale : c’est l’équipe de conception qui fait des choix en fonction de valeurs (transparence, sobriété, etc.).

- Interface et application : C’est un niveau souvent sous-estimé dans le grand public. L’interface, c’est la manière dont les résultats du modèle sont présentés et mis à disposition. C’est aussi là qu’on peut ajouter des règles métier. Par exemple, un même modèle de langage, GPT-4, peut être intégré dans un chatbot grand public comme ChatGPT, ou dans un moteur de recherche comme Bing, ou encore dans un assistant d’écriture dans Word. Dans chaque cas, l’application autour du modèle va le spécialiser : Bing va, par conception, adosser le LLM à des recherches web et citer ses sources ; Word va surtout aider à reformuler du texte de l’utilisateur ; ChatGPT va dialoguer librement. L’éthique perçue par l’utilisateur dépend en grande partie de cette couche applicative : transparence sur le fait qu’on parle à une machine, présence de filtres de modération, explications fournies ou non avec les réponses, etc. C’est pourquoi les entreprises insistent sur la notion de « Responsible AI » dans le déploiement : Microsoft, par exemple, publie des guides de conception éthique pour l’IA intégrée à ses produits. Une interface bien conçue peut prévenir beaucoup d’usages abusifs (par exemple en limitant les fonctionnalités dans certains contextes, ou en éduquant l’usager via des messages d’avertissement).

- Utilisateur et usage : Enfin, l’éthique dépend bien sûr de ce qu’en fait l’utilisateur final. Un même modèle peut être utilisé de façons opposées d’un point de vue moral : on peut s’en servir pour aider (éducation, créativité, accessibilité aux personnes en situation de handicap) ou pour nuire (propagande de haine, spam, triche aux examens, etc.). C’est ici que la comparaison avec d’autres outils est la plus parlante. Par exemple, l’invention de l’imprimerie au XVe siècle a permis aussi bien de diffuser le savoir que de propager des pamphlets dangereux ; le marteau peut construire une maison ou être une arme contondante. Ce n’est pas le marteau qu’on va juger en tant que bon ou mauvais, c’est l’acte de frapper avec de mauvaises intentions. De même, si un élève utilise ChatGPT pour réaliser un devoir entier sans mentionner la source, c’est un problème d’intégrité académique de sa part, pas la faute intrinsèque du modèle. En revanche, on pourra considérer que l’institution scolaire doit adapter ses règles (ex : tolérer l’IA comme aide à condition de citer, ou au contraire bannir son usage pour certains travaux, et dans tous les cas éduquer les élèves à son usage raisonné).

Ce découpage montre que la notion d’« éthique d’un modèle d’IA » pris isolément est trop réductrice. Comme l’énonce la première loi de Kranzberg en histoire des technologies, « la technologie n’est ni bonne, ni mauvaise, ni neutre ». Par là, il faut comprendre que ce qui compte ce sont les conséquences et l’insertion de la technologie dans la société. Un LLM peut faire du bien ou du mal selon l’usage : c’est donc sur la gouvernance de son utilisation qu’il faut mettre l’accent. D’ailleurs, les régulateurs l’ont bien saisi : le projet de Règlement Européen sur l’IA (AI Act) n’interdit pas « les LLM » en tant que tels, mais propose une classification par niveaux de risque selon les usages (par exemple, usage dans le recrutement, dans la notation de crédit, dans un jouet interactif pour enfants, etc., avec des obligations différentes). On tend à encadrer les usages à risque plutôt que la technologie elle-même. Certains experts comme Luc Julia alertent toutefois sur une surrégulation pouvant brider l’innovation si elle est trop générale : il préconise de réguler a posteriori les abus avérés plutôt que d’interdire a priori des approches entières, soulignant qu’« interdire globalement certaines technologies plutôt que des applications spécifiques […] risque de bloquer l’innovation ». Là encore, on voit l’importance de la granularité dans l’analyse éthique : ce n’est pas l’algorithme mathématique qu’il s’agit de moraliser, mais bien ses implications concrètes (comment on l’entraîne, l’emploie, l’oriente, qui en répond en cas de problème).

Conclusion : Pas d’éthique sans humains – recontextualiser la morale des IA

En explorant ces différentes idées reçues, nous avons constaté que les arguments pour qualifier un LLM de « non éthique par essence » résultent souvent d’une confusion de niveaux. Oui, les modèles d’IA générative peuvent produire des outputs biaisés, imprévisibles, voire juridiquement litigieux. Mais ces travers proviennent de choix et de situations imputables à l’action humaine (directement ou indirectement) plutôt qu’à une quelconque volonté propre du modèle.

Un LLM n’est pas une entité douée de morale : c’est un assemblage de techniques (réseaux de neurones, probabilités) qui reproduit statistiquement des formes linguistiques. Lui attribuer une éthique intrinsèque revient à commettre un anthropomorphisme déplacé. Comme l’affirme Luc Julia, « l’intelligence est réservée au vivant », sous-entendu ce que produisent ces systèmes n’est pas de l’intelligence – et a fortiori pas de la moralité – au sens où nous l’entendons pour l’humain. Par contre, les décisions humaines autour de ces modèles sont, elles, chargées de valeurs morales : quels jeux de données utilise-t-on (respecte-t-on tel principe ou telle loi) ? Que programme-t-on comme comportement par défaut (par exemple, doit-il refuser de tenir des propos haineux, même si l’utilisateur le demande) ? Comment intègre-t-on l’outil dans la société (transparence, formation des usagers, limites d’usage) ? C’est à ces niveaux que se joue l’éthique.

Ainsi, plutôt que de se demander si « le modèle est éthique », il faut poser d’autres questions bien plus pertinentes : comment le rendre aussi digne de confiance que possible ? Comment corriger et limiter ses biais ? Quel usage légitime en faire, et dans quel cadre ? Quelles responsabilités pour les développeurs, les entreprises qui le diffusent, et les utilisateurs finaux ? Cette approche proactive est illustrée par de nombreuses initiatives : chartes d’éthique de l’IA dans les organisations, comités interdisciplinaires évaluant l’impact des algorithmes, améliorations techniques continues (comme l’optimisation des paramètres, le fine-tuning sur des corpus spécialisés moins biaisés, l’ajout de modules d’explicabilité, etc.).

En milieu éducatif et académique, où se trouvent nos principaux lecteurs, cela implique de former les étudiants et collègues à un usage réfléchi de ces outils. Les IA génératives ne doivent pas être diabolisées ni idéalisées : il faut en comprendre les forces et faiblesses. On peut par exemple apprendre aux élèves à détecter les limites d’une réponse fournie par IA, à la vérifier et à la compléter par des sources fiables. De même, dans la recherche, l’IA peut accélérer la revue de littérature, mais un chercheur se doit de vérifier les références citées (car le modèle peut en inventer). L’éthique professionnelle du chercheur ou de l’enseignant s’applique : citation des sources, vérification des faits, respect de la propriété intellectuelle – autant de principes qui restent valables, que l’on utilise une IA ou non. En fait, l’arrivée des LLM rend ces principes encore plus cruciaux : ils sont nos boussoles dans un océan d’informations générées automatiquement.

Pour conclure, les modèles d’IA générative eux-mêmes sont des outils amoraux – ni moraux ni immoraux – et ne sauraient être étiquetés globalement d’« éthiques » ou « non éthiques » sans préciser le contexte. C’est l’usage qui en est fait et le cadre mis en place autour d’eux qui permet d’en faire des alliés bénéfiques ou au contraire des sources de problèmes. L’éthique de l’IA est donc avant tout une éthique humaine, qu’il s’agisse de concepteurs responsables, d’utilisateurs avertis ou de législateurs vigilants. Plutôt que de condamner la technologie dans son essence, adoptons une démarche de responsabilité partagée, où chaque acteur – du développeur à l’utilisateur – joue son rôle pour que ces puissants modèles servent au mieux nos valeurs et le bien commun, en minimisant leurs risques. Ce n’est qu’à ce prix que nous pourrons profiter en confiance des apports des IA génératives, tout en conservant le contrôle éthique de leur place dans notre société.

Sources citées : Les références utilisées dans cet article incluent des experts français comme Luc Julia, des analyses de juristes sur ChatGPT et le droit d’auteur, des études sur les biais des IA, ainsi que des exemples concrets d’entreprises et de chercheurs œuvrant pour une IA plus transparente et équitable (Une IA éthique concurrente de ChatGPT n’empiétant pas sur le droit d’auteur ? Cette start-up française y croit !). Ces sources illustrent et appuient chaque point développé, afin d’offrir une vision à la fois critique et nuancée de l’éthique appliquée aux modèles de langage. En définitive, retenir que la question éthique dépasse le seul modèle permet d’éviter les faux procès et de concentrer les efforts là où ils sont le plus utiles : sur la manière d’élaborer et d’employer l’IA de façon responsable.